牛客面试题

Spring-牛客面经八股

1. 说说 Spring Boot 常用的注解

@SpringBootApplication:组合注解(@Configuration+@EnableAutoConfiguration+@ComponentScan),应用入口常放在主类上。@Configuration/@Bean:定义配置类和显式创建 Bean。@Component/@Service/@Repository/@Controller/@RestController:组件扫描管理类;@RestController = @Controller + @ResponseBody。@Autowired/@Qualifier/@Value/@Resource:依赖注入、按类型/按名称注入、读取配置。@ConfigurationProperties:将一组配置绑定到 POJO(推荐用于复杂配置)。@EnableAutoConfiguration(隐含在@SpringBootApplication中):启用自动配置。- 条件注解(常用于自动配置类):

@ConditionalOnClass、@ConditionalOnMissingBean、@ConditionalOnProperty、@ConditionalOnBean等。 @Transactional:声明式事务。@RestControllerAdvice/@ControllerAdvice:统一异常/全局处理。- 测试相关:

@SpringBootTest、@WebMvcTest、@DataJpaTest等。 - 其他:

@EnableScheduling、@EnableCaching、@EnableFeignClients、@EnableDiscoveryClient等(看用到的组件)。

示例:

1 |

|

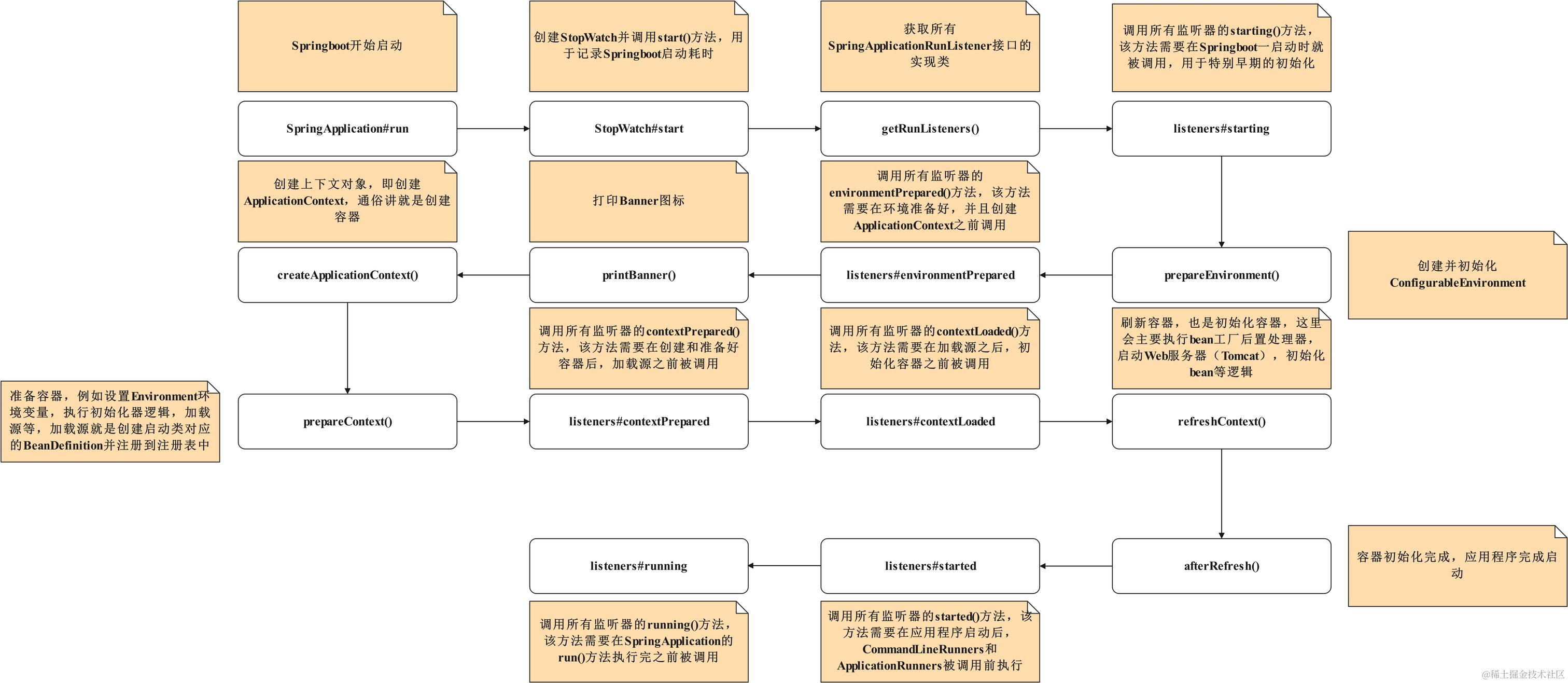

2.Spring Boot 启动流程

入口一般是:

1 |

|

- 作用:创建一个

SpringApplication实例,准备运行环境。 - 关键点:

- 判断当前应用类型(

NONE、SERVLET、REACTIVE),决定用什么样的ApplicationContext。 - 加载并设置

ApplicationContextInitializer和ApplicationListener。

- 判断当前应用类型(

- 事件:

ApplicationStartingEvent。 - 触发时机:Spring 环境还未初始化前。

- 用途:做一些极早期的日志初始化、Banner 输出等。

- 工作内容:

- 创建

ConfigurableEnvironment(不同应用类型对应不同环境类)。 - 加载配置源:系统属性、环境变量、命令行参数、

application.properties/application.yml、@PropertySource。 - 执行

ConfigFileApplicationListener,解析并注入配置文件属性。

- 创建

- 扩展点:可通过

EnvironmentPostProcessor在环境准备阶段修改/添加配置。

- 默认情况:

- 普通应用 →

AnnotationConfigApplicationContext - Web Servlet 应用 →

AnnotationConfigServletWebServerApplicationContext - Web Reactive 应用 →

AnnotationConfigReactiveWebServerApplicationContext

- 普通应用 →

- 扩展点:可通过

SpringApplication.setApplicationContextClass()自定义上下文类型。

- 作用:在

ApplicationContext刷新之前,可以对其进行个性化处理。 - 加载方式:

spring.factories中的ApplicationContextInitializer。SpringApplication.addInitializers(...)手动添加。

- 应用场景:在容器 refresh 前注册属性源、配置 BeanDefinition 等。

- 关键机制:

@EnableAutoConfiguration触发AutoConfigurationImportSelector。- 从

META-INF/spring.factories或META-INF/spring/org.springframework.boot.autoconfigure.AutoConfiguration.imports加载所有候选配置类。 - 通过

@ConditionalOnClass、@ConditionalOnBean、@ConditionalOnMissingBean等条件注解筛选。

- 结果:按需装配 starter 中的 Bean(如

DataSourceAutoConfiguration、WebMvcAutoConfiguration等)。

- 代表类:

ConfigurationClassPostProcessor:解析@Configuration类、@ComponentScan、@Import、@Bean等注解。- 其他定制的

BeanFactoryPostProcessor。

- 扩展点:可以在 BeanDefinition 阶段修改 bean 的元数据。

过程:

- 实例化(调用构造器)。

- 依赖注入(populate 属性)。

- 回调 Aware 接口(如

BeanNameAware、ApplicationContextAware)。 - BeanPostProcessor#postProcessBeforeInitialization。

- 初始化方法(

@PostConstruct、InitializingBean.afterPropertiesSet()、自定义 init-method)。 - BeanPostProcessor#postProcessAfterInitialization`。

- 最终放入一级缓存(

singletonObjects)。

- 标志事件:

ApplicationStartedEvent:容器启动完成。ApplicationReadyEvent:应用准备好接收请求。

- 其他事件:

ContextRefreshedEvent(上下文刷新完成)。WebServerInitializedEvent(WebServer 启动完成)。

- 成功:Web 应用启动,内嵌 Tomcat/Jetty/Undertow 已经监听端口。

- 失败:触发

ApplicationFailedEvent,进入FailureAnalyzers分析错误并输出人性化提示。

🔑 重要扩展点总结

ApplicationListeners:贯穿整个生命周期,可监听各种事件。

ApplicationContextInitializer:在容器刷新前定制化上下文。

BeanFactoryPostProcessor:修改 BeanDefinition。

BeanPostProcessor:定制 Bean 实例化前后行为。

@ConditionalOn…:自动配置的核心。

3. 对 IoC(Inversion of Control / 依赖注入)的理解

- 本质:把对象的创建和依赖的组装(控制权)从类内部移到容器(Spring)来管理——“控制反转”。实际表现为依赖注入(Dependency Injection)。

- 优点:解耦(组件只声明依赖,不负责创建)、易测试(可以注入 mock)、统一管理生命周期、便于 AOP 切面化。

- 注入方式:构造器注入(推荐,强制依赖、利于测试)、setter 注入、字段注入(简便但不推荐)。

- 容器职责:管理 bean 的实例化、装配、生命周期、作用域(singleton/prototype/request/session)等。

4. 对 AOP(面向切面编程)的理解

- 目的:把横切关注点(日志/事务/安全/缓存等)从业务代码分离出来。

- 术语:切面(Aspect)、通知(Advice:before/after/around/afterReturning/afterThrowing)、连接点(Join point)、切入点(Pointcut)、目标对象(Target)、代理(Proxy)。

- 实现方式:Spring 默认基于代理(JDK 动态代理:接口;CGLIB:类代理);也可用 AspectJ(编译/类加载期织入)实现更强的能力。

- 常见限制:代理是对象外部的包装 → 自身(同类)方法调用不会触发代理(self-invocation 问题);可用

AopContext.currentProxy()或 AspectJ 解决,或将需要切面的调用拆到另一个 bean。 - 使用示例(注解式):

1 |

|

5. Bean 的生命周期(主要步骤与钩子)

- 实例化(instantiate bean)

- 依赖注入(populate properties)

- Aware 接口回调:

BeanNameAware.setBeanName()、BeanFactoryAware.setBeanFactory()、ApplicationContextAware.setApplicationContext()等 BeanPostProcessor.postProcessBeforeInitialization(...)- 初始化回调:

@PostConstruct、afterPropertiesSet()(InitializingBean)、自定义init-method BeanPostProcessor.postProcessAfterInitialization(...)→ Bean 就绪可用(在容器中)- 销毁(单例在容器关闭时):

@PreDestroy、DisposableBean.destroy()、自定义destroy-method。

- 另外:

SmartLifecycle、InitializingBean、DisposableBean、BeanFactoryPostProcessor、BeanPostProcessor等都参与生命周期扩展。

6. @Autowired 和 @Resource 的区别

- 来源:

@Autowired是 Spring 注解;@Resource是 JSR-250(Java 标准)。 - 注入方式:

@Autowired:按 类型(byType) 注入;若有多个候选可结合@Qualifier或@Primary。支持required(默认true,可设false)或Optional<T>/@Nullable。支持构造器/字段/setter。@Resource:默认按 名称(byName) 注入(会先按 name 属性或字段名匹配 bean 名称),若找不到则回退按类型注入。没有required属性。

- 使用习惯:

@Autowired更常见(Spring 风格);如果需要严格按 bean 名称注入可用@Resource(name="...")。 - 另外:

@Inject(JSR-330)类似@Autowired(按类型)。

7. Spring 事务管理

- 两种方式:声明式(

@Transactional最常见)和编程式(PlatformTransactionManager+TransactionTemplate)。 - 事务管理器(常见):

DataSourceTransactionManager(JDBC)、JpaTransactionManager(JPA/Hibernate)、JtaTransactionManager(分布式/XA)。 @Transactional常用属性:propagation、isolation、readOnly、timeout、rollbackFor/noRollbackFor。- 传播行为(常用几种):

REQUIRED(默认):如果有事务就加入,否则新建。REQUIRES_NEW:挂起当前事务,另启新事务(独立提交/回滚)。NESTED:在同一物理连接上通过 savepoint 实现“子事务”(回滚到 savepoint),只有支持 JDBC 的事务管理器才有效。SUPPORTS、NOT_SUPPORTED、MANDATORY、NEVER等。

- 回滚规则:默认对 unchecked(

RuntimeException、Error)回滚;若要对 checked exception 回滚需指定rollbackFor。 - 注意点:

@Transactional通过 AOP 代理实现(代理对象拦截方法并管理事务),因此同类内部方法调用不会走代理,事务注解不会生效(self-invocation)。解决办法:把方法放到另一个 bean、使用AspectJ或手动通过TransactionTemplate。 - 事务与连接:Spring 管理 JDBC 连接绑定到线程(事务同步),propagation 影响是否复用或者新开连接。

8. Spring MVC 的执行流程(请求到响应的完整链路)

简化流程(按实际处理顺序):

- 客户端请求 → 到

DispatcherServlet(前端控制器,Front Controller)。 HandlerMapping根据 URL 找到对应的 Handler(Controller 方法,内部为HandlerMethod)。- 执行

HandlerInterceptor.preHandle()(可拦截、返回 false 终止)。 HandlerAdapter调用 Controller 方法:内部会执行HandlerMethodArgumentResolver(解析方法参数)和HandlerMethodReturnValueHandler(处理返回值)。对于@ResponseBody/ 返回对象,会交给HttpMessageConverter序列化(JSON/XML)。- Controller 返回

ModelAndView或视图名或响应体。 HandlerInterceptor.postHandle()(可修改 ModelAndView)。ViewResolver解析视图,View渲染最终响应;若@ResponseBody,则直接写出。HandlerInterceptor.afterCompletion()(清理工作),以及ExceptionResolver处理异常路径。

关键扩展点:拦截器、过滤器、异常处理器(@ControllerAdvice / HandlerExceptionResolver)、参数解析(@RequestParam、@PathVariable、@RequestBody)等。

9. @Component 和 @Bean 的区别

@Component:类级注解,交给组件扫描自动发现并注册为 bean。适合你自己写的类。@Bean:方法级注解,放在@Configuration类中,由方法的返回值注册为 bean。适合第三方类或需要程序化创建的 bean。- 细节区别:

@Configuration类会被 CGLIB 代理以保证@Bean方法的单例语义(同一配置类内调用@Bean方法会返回容器中的单例,而不是新实例)。@Component比较“自动”,@Bean更显式、可编程(可以在方法中做复杂逻辑)。- 注入优先级/覆盖规则:

@Bean定义的 bean 名称可和扫描到的组件冲突,容器按注册顺序/配置决定覆盖或报错(可用@Primary、@Order或显式排除)。

10. Spring 中用到的设计模式

- 单例模式(Singleton):Spring 的单例 scope(容器保证)。

- 工厂模式(Factory) / 抽象工厂:

BeanFactory/ApplicationContext提供getBean。 - 代理模式(Proxy):AOP 使用(JDK 动态代理 / CGLIB)。

- 模板方法模式(Template Method):

JdbcTemplate,JmsTemplate等,封装固定流程,留钩子给子类/回调。 - 策略模式(Strategy):可插拔的实现选择,如不同的序列化/编码/厂商策略、事务策略。

- 观察者模式(Observer):

ApplicationEvent/ApplicationListener。 - 前端控制器(Front Controller):

DispatcherServlet。 - 适配器模式(Adapter):

HandlerAdapter用于适配不同 handler。 - 责任链(Chain of Responsibility):Servlet Filter 链、Spring Security 的 filter chain、Interceptor 链。

- 门面模式(Facade):例如

JdbcTemplate对复杂 JDBC 操作的简化封装。

11. Spring 循环依赖是什么?介绍下三级缓存

- 循环依赖:A -> B -> A 的依赖关系。Spring 能自动解决部分场景(单例 bean 且为 setter/属性注入 的情况可以解决;构造器注入 则无法解决)。

- 三级缓存(三缓存)(Spring 单例循环依赖解决的核心):

- singletonObjects(一级缓存)——完全初始化好的单例 bean 实例(最终放这里)。

- earlySingletonObjects(二级缓存)——提前曝光的 bean 实例(未完成初始化但可以被其它 bean 引用,通常用于原始对象或早期代理)。

- singletonFactories(三级缓存)——保存一个

ObjectFactory,当需要早期引用时可以调用它得到(常用于创建代理对象,支持 AOP 情况)。

- 简要流程(创建 bean A):

- 实例化 A(还没注入属性)。把 A 的

ObjectFactory放入singletonFactories(使别人能拿到早期引用)。 - 当创建 B 时需要 A,会先从

singletonObjects看不到,再从earlySingletonObjects/singletonFactories找到早期引用并加入earlySingletonObjects。 - B 的注入完成后返回,A 完成属性注入、执行后置处理器,最后把 A 放入

singletonObjects,并从早期缓存移除。

- 实例化 A(还没注入属性)。把 A 的

- 限制 & 注意:

- 只能解决单例且非构造器注入的循环依赖;构造器注入需要构造函数就得到依赖,无法提前暴露,故会抛异常。

- AOP 代理会影响:默认如果需要代理,Spring 会在

singletonFactories存入创建代理的工厂,这样早期引用能得到代理,避免后续再创建新的代理导致不一致。 - Prototype scope(原型)不支持自动解决循环依赖。

12. Spring Security 是什么?

- Spring Security 是一个提供认证(Authentication)与授权/访问控制(Authorization)的企业级安全框架,功能包括:登录/登出、权限控制、方法级安全、会话管理、CSRF 防护、加密密码、集成 OAuth2 / OIDC / SSO 等。

- 主要组件:

SecurityFilterChain(一系列 Filter 拦截与安全处理)、AuthenticationManager、UserDetailsService(加载用户信息)、GrantedAuthority(权限)、密码编码器(如BCryptPasswordEncoder)、MethodSecurity(@Secured、@PreAuthorize)等。 - 集成点:与 Spring MVC / WebFlux 无缝集成,常用配置有基于 DSL 的 Java Config(Spring Security 5+ 风格)以及注解式方法安全。

13. Spring、Spring MVC、Spring Boot 三者之间的关系

- Spring Framework:底层核心框架,提供 IoC(依赖注入)、AOP、事务管理、数据访问支持等基础功能。

- Spring MVC:Spring 的一个模块(web 框架),实现 MVC 模式,基于 Spring 的 IoC/AOP 运行,负责处理 HTTP 请求、分发到 Controller、渲染视图等。

- Spring Boot:基于 Spring 的约定优于配置(opinionated)框架,简化 Spring 应用的配置与启动(starter 依赖、自动配置、嵌入式容器、Actuator 等)。它不是替代 Spring,而是简化使用 Spring(及 Spring MVC、Spring Data、Spring Security 等生态)的方式。

简单:Spring = 基础,Spring MVC = Web 模块,Spring Boot = 用来快速启动/配置 Spring 应用的工具集与约定。

14. Spring Boot 自动配置原理(原理概述)

- 核心:

@EnableAutoConfiguration(隐含在@SpringBootApplication)通过AutoConfigurationImportSelector导入大量候选自动配置类。 - 自动配置类通常放在

org.springframework.boot.autoconfigure.*,并带有条件注解(@ConditionalOnClass、@ConditionalOnMissingBean、@ConditionalOnProperty等)来决定是否生效。 - 自动配置候选的来源:传统上通过

META-INF/spring.factories列表来发现(Spring Boot 2.x 常用),较新的 Boot 版本引入了更现代的自动配置注册机制(也使用 metadata 文件来列出 auto-config 类)。无论机制如何,核心思想是:按需注册、并允许用户通过spring.autoconfigure.exclude或@SpringBootApplication(exclude=...)覆盖/排除。 - 覆盖顺序:用户显式定义的

@Bean通常优先于自动配置;自动配置通过条件注解判断是否装配。 - 常用条件注解举例:

@ConditionalOnClass(类在类路径中时生效)、@ConditionalOnMissingBean(当容器中没有某 bean 时生效)、@ConditionalOnProperty(基于配置属性启用/禁用)。

提示:自动配置是“约定优于配置”的实现:在默认配置无法满足时,用户可通过自定义配置/排除来自定义行为。

15. Spring Cloud 的组件有哪些?(常见模块与作用)

Spring Cloud 是一套构建分布式系统的工具集合,包含很多子项目。常见模块(并非全部):

- Spring Cloud Config:集中式配置管理(server + client)。

- Spring Cloud Netflix(整合 Netflix OSS):Eureka(服务发现)、Ribbon(客户端负载均衡,已在新版本逐步被

Spring Cloud LoadBalancer取代)、Hystrix(断路器,已进入维护/弃用,替代方案Resilience4j)。 - Spring Cloud Gateway:API 网关/路由。

- OpenFeign / Spring Cloud OpenFeign:声明式 HTTP 客户端。

- Spring Cloud LoadBalancer:客户端负载均衡(替代 Ribbon)。

- Spring Cloud CircuitBreaker:抽象断路器,支持 Resilience4j 等实现。

- Spring Cloud Stream:事件/消息驱动(Kafka/RabbitMQ 绑定)。

- Spring Cloud Bus:消息总线(广播配置刷新等)。

- Spring Cloud Sleuth / Zipkin / Micrometer:分布式追踪与监控。

- Spring Cloud Gateway / Zuul(老):API 路由/网关实现。

- Spring Cloud Contract:契约测试。

- Spring Cloud Kubernetes / Consul / Zookeeper:与 k8s、Consul、ZK 的整合。

注:Spring Cloud 生态很大,不同版本间有替代与弃用(例如 Ribbon -> LoadBalancer,Hystrix 逐步被 Resilience4j 取代),实际项目中按需要选用。

16. 在 REQUIRES_NEW 场景下,子事务同时操作同一数据会发生什么?

这是一个非常实战且需要深入理解数据库事务模型与 Spring 事务传播差异的问题。下面分几部分说明:实现细节、并发与隔离语义、可能的异常/问题、解决方案/最佳实践。

(A)REQUIRES_NEW 的行为(实现层面)

REQUIRES_NEW会 挂起 当前(外层)事务,然后在一个 独立的事务 中执行子事务。实现上(本地事务)通常意味着:挂起外层事务的连接/事务状态,取得新的数据库连接(或从连接池取出),在该连接上开启新的事务;子事务完成后提交/回滚并关闭该连接,然后恢复外层事务继续执行(用原来的连接与事务)。- 结果:子事务的提交或回滚 与外层事务相互独立(子事务已提交后,即使外层后续回滚,也无法回滚子事务)。

(B)若子事务和外层/另一个子事务“同时”操作同一数据,会发生什么?

行为由 数据库隔离级别、锁机制(悲观锁 / 行级锁)、以及操作顺序决定。常见情况:

- 子事务在另一个事务之后提交(顺序不同)

- 若两个事务更新同一行,数据库会对行加锁(具体行为依 DB 引擎)。例如 InnoDB(MySQL)执行

UPDATE会加行锁。第二个事务会在尝试修改时等待第一个事务释放锁(或触发死锁检测)。最终一个事务会被回滚(DB 检测到死锁)或等待成功后提交。Spring 会把底层 SQLException 转为DataAccessException抛出,事务会相应回滚或提交。

- 若两个事务更新同一行,数据库会对行加锁(具体行为依 DB 引擎)。例如 InnoDB(MySQL)执行

- 并发读写 + 隔离级别影响(READ_COMMITTED vs REPEATABLE_READ)

- READ_COMMITTED:每条语句看到的是已提交的数据;如果子事务提交后,外层事务在挂起后恢复并重新读取,会看到子事务的修改。

- REPEATABLE_READ(MySQL 默认):事务开始时建立读快照;在外层事务尚未提交且使用 REPEATABLE_READ 时,外层事务可能不会看到子事务提交的更改,直到外层事务结束并重新开始事务。

- 因此:数据可见性取决隔离级别与何时读取。

- 丢失更新(Lost Update)

- 场景:T1(外层)读到值

v→ 执行 REQUIRES_NEW 的子事务 T2 更新为v2并提交 → T1 继续基于旧v计算并写回 → 如果没有版本控制/锁机制,会覆盖 T2 的更新(丢失更新)。

- 场景:T1(外层)读到值

- 悲观锁 / 乐观锁的影响

- 悲观锁(SELECT … FOR UPDATE):可以避免并发写冲突(会阻塞直到锁释放)。

- 乐观锁(version 字段):写时检查版本号,不匹配则抛出

OptimisticLockingFailureException,开发者可捕获重试以解决冲突。

(C)与 NESTED 的对比(重要)

NESTED在多数实现下使用 同一物理连接 + savepoint 实现:子事务回滚只是回到 savepoint,不会独立提交。REQUIRES_NEW是独立事务并提交后不可撤销。- 因此:若想实现“子事务失败不影响外层”且不希望子事务独立提交,

NESTED比REQUIRES_NEW更合适(但需 DB & 事务管理器支持)。

(D)JPA/Hibernate 细节(ORM 层的问题)

- 使用 JPA/Hibernate 时,

REQUIRES_NEW会创建新的EntityManager/ persistence context。外层事务的持久化上下文(1st-level cache)在恢复后仍保留旧实体的状态(可能是陈旧的)。因此:外层事务需要entityManager.refresh(entity)或entityManager.clear()来看到子事务的修改,否则可能基于陈旧实体写回,导致覆盖或冲突。 - 注意:

REQUIRES_NEW额外创建连接/实体管理器,开销较大,且更容易产生并发冲突需要手工处理。

(E)示例场景(伪代码,说明丢失更新):

1 | // 外层事务 T1 |

结论:若不处理,可能出现覆盖/丢失更新或不可预期的数据一致性问题。

(F)数据库级别的异常(死锁、序列化失败等)

- 并发更新同一资源可引发死锁,DB 会回滚其中一个事务并抛出异常(例如 MySQL 的死锁错误)。Spring 捕获后会抛出 DataAccessException 或其子类,事务回滚。需要在调用方处理(重试或降级)。

- 在更严格隔离(

SERIALIZABLE)下可能出现序列化异常,也需要重试逻辑。

(G)最佳实践与建议

- 明确事务边界:不要随意大量使用

REQUIRES_NEW,它会增加连接数和复杂度。只在确实需要“子事务独立提交”的场景使用(如写审计日志、发送外部不可回滚的操作)。 - 避免丢失更新:对重要并发更新场景使用**乐观锁(version)**或**悲观锁(SELECT … FOR UPDATE)**。

- 在 JPA 场景谨慎处理 Persistence Context:

REQUIRES_NEW后如果外层要使用被子事务修改的实体,记得refresh()或clear(),以避免使用 stale entity。 - NESTED vs REQUIRES_NEW:如果想在同一物理事务里局部回滚用 NESTED(savepoint),想要真正独立提交用 REQUIRES_NEW。

- 处理异常与重试:对可能的死锁/序列化冲突做重试策略(指数退避等)。Spring 的

@Transactional不会自动重试,需自己实现。 - 监控与容量注意:

REQUIRES_NEW增加并发连接数,注意数据库连接池容量。

小结(关于第16题的实战提醒)

REQUIRES_NEW会产生独立事务并独立提交。若外层/其他事务同时对同一数据修改,最终行为取决于 DB 的锁与隔离级别:会有等待、死锁、丢失更新或序列化冲突等情况。- 解决思路:用乐观锁/悲观锁、合理选择传播行为(NESTED vs REQUIRES_NEW)、在 ORM 场景刷新/清理持久化上下文、并实现重试策略与良好的异常处理。

Java基础-牛客面经八股

1 Java 基本数据类型与引用类型

1. 基本类型(Primitive Types, 8 种)

- 类型:

byte(1B)、short(2B)、int(4B)、long(8B)、float(4B)、double(8B)、char(2B, UTF-16 code unit)、boolean(大小未在 JVM 规范中强制规定,通常用 1 bit/1 byte 存储)。 - 存放位置:

- 方法里的局部变量 → JVM 栈帧的局部变量表(直接存值)。

- 如果是对象的字段 → 存在 堆内存的对象布局中(对象头 + 实例字段 + 对齐填充)。

- 优点:

- 直接值语义,没有引用开销。

- 不参与 GC,性能高。

- 内存占用小。

- 缺点:

- 不能为

null。 - 不具备面向对象特性(没有方法)。

- 不能为

2. 引用类型(Reference Types)

- 类型:类、接口、数组、枚举、注解。

- 存放方式:

- 引用变量 存在栈或对象字段中,存储的是对象在堆上的地址(引用)。

- 对象本体 存在堆中(对象头 + 实例数据 + 对齐)。

- 特点:

- 可以为

null。 - 传递时是 值传递,但值是引用的拷贝(可能导致“看起来像引用传递”)。

- 需要 GC 管理生命周期。

- 可以为

3. 内存结构对比

- 基本类型字段:直接存值,结构紧凑。

- 包装类型(如

Integer):对象有对象头(MarkWord + Klass 指针)+ 实例数据(int 值)+ 对齐填充。内存占用比基本类型大得多(通常至少 16B+)。 - 布尔类型:虽然语义是 true/false,但在对象中至少占 1B(HotSpot 会优化压缩到 bitset,但不保证)。

Q1. 为什么 Java 有基本类型而不是全部用对象?

👉 回答要点:

- 性能考虑。

- 基本类型避免了对象包装的额外开销(对象头、GC、指针寻址)。

- 在高频计算(循环、数值运算)中,大量创建对象会显著拖慢性能。

Q2. 基本类型和包装类型的区别?

👉 回答要点:

- 基本类型直接存值,包装类型是对象(有引用开销)。

- 包装类型可以为

null,而基本类型不行。 - 包装类型支持方法(如

Integer.valueOf、compareTo)。 - 自动装箱/拆箱可能引发性能问题。

- 比较时:

- 基本类型用

==比较值。 - 包装类型

==比较引用(除非在 [-128,127] 缓存范围内的整型)。

- 基本类型用

Q3. 为什么 Integer i1 = 127; Integer i2 = 127; i1 == i2 返回 true,而换成 128 返回 false?

👉 回答要点:

- 因为 Java 对

Integer做了缓存(IntegerCache,默认缓存 -128 ~ 127)。 - 超出范围会创建新的对象。

Q4. 对象在堆中的内存布局是怎样的?

👉 回答要点:

- 对象头:

- Mark Word(哈希码、锁信息、GC 信息)。

- Klass Pointer(指向类元数据)。

- 实例数据:成员变量。

- 对齐填充:保证 8 字节对齐。

Q5. 为什么建议用不可变对象(String, Integer, Long 等)作为共享数据?

👉 回答要点:

- 不可变 → 线程安全,不需要额外同步。

- 可作为 Map 的 key(不会被修改导致 hashCode 变化)。

- 方便缓存(如 String Pool)。

Q6. 什么时候用基本类型,什么时候用包装类型?

👉 回答要点:

- 优先用基本类型 → 性能敏感场景(循环计数器、数值计算)。

- 必须用包装类型 →

- 需要使用泛型(

List<Integer>)。 - 需要为

null表示缺省值。 - 需要调用包装类的方法。

- 需要使用泛型(

Q7. 为什么 boolean 大小未定义?JVM 实际是怎么处理的?

👉 回答要点:

- JVM 规范只定义了 boolean 的语义,没有强制大小。

- 实际实现:

- 在数组中,boolean 常按 byte 存储。

- 在对象字段中,HotSpot 常把 boolean 当成 1B,但可能和其他字段合并压缩(bitfield)。

🔹 面试小结

- 基本类型 → 性能好,存值,不可为 null。

- 引用类型 → 面向对象特性,存引用,需 GC 管理。

- 面试重点:装箱拆箱、缓存机制、对象内存布局、堆 vs 栈、不可变对象的好处。

🔹 栈(Stack)

- 定义:线程私有,每个线程启动时会创建一个栈,生命周期和线程相同。

- 存放内容:

- 局部变量(基本类型的值 / 引用变量的引用值)。

- 方法调用信息(局部变量表、操作数栈、动态链接、返回地址)。

- 特点:

- 内存小但访问快(栈帧出栈后,内存直接复用)。

- 线程隔离,不需要同步 → 天然线程安全。

- 方法调用结束 → 栈帧自动销毁,无需 GC。

- 错误场景:

- 递归过深或方法调用层次过多,会导致 StackOverflowError。

🔹 堆(Heap)

- 定义:Java 内存最大的一块,所有线程共享。

- 存放内容:

- 对象实例(无论是成员变量还是数组)。

- 对象的实例数据(字段)。

- 特点:

- 所有线程共享,需要 GC 来管理生命周期。

- 内存分配比栈复杂(对象需要内存分配、布局、回收)。

- 大小可配置(

-Xmx/-Xms)。

- 错误场景:

- 堆不足时 → OutOfMemoryError: Java heap space。

🔹 对比总结

| 对比点 | 栈 | 堆 |

|---|---|---|

| 管理 | 方法调用自动分配/销毁 | JVM GC 管理 |

| 存储内容 | 基本类型的值、引用的地址 | 对象实例、成员变量 |

| 线程安全 | 线程私有,安全 | 线程共享,需同步 |

| 生命周期 | 方法结束自动销毁 | 对象被 GC 回收 |

| 错误 | StackOverflowError |

OutOfMemoryError |

🔹 常见面试追问

Q1. Java 中的变量存放在堆还是栈?

👉 回答要点:

- 基本类型的局部变量 → 存在栈里。

- 引用变量(如

Person p) → 引用存在栈里,实际对象在堆里。 - 对象字段(即使是基本类型) → 随着对象存放在堆里。

Q2. 为什么栈比堆快?

👉 回答要点:

- 栈是顺序内存结构,分配/释放只移动栈顶指针 → O(1)。

- 堆分配需要找合适的内存块,还要涉及 GC,成本高。

Q3. 栈里能存对象吗?

👉 回答要点:

- 严格来说,对象实例只能在堆中存。

- 栈里只能存对象引用(指向堆)。

- 但 JVM 的 JIT 优化可能会做逃逸分析,把未逃出方法的对象分配到栈上(Stack Allocation),甚至标量替换 → 提高性能。

Q4. 为什么要有堆和栈的区分?

👉 回答要点:

- 栈 → 方法调用和局部变量,高效且线程私有。

- 堆 → 对象共享,生命周期不固定,只能靠 GC。

- 各自职责清晰,才能兼顾性能和灵活性。

Q5. GC 只回收堆吗?

👉 回答要点:

- 对,GC 主要回收堆内存。

- 栈内存是随着方法出栈自动释放的,不需要 GC。

🔹 面试快速答题版

- 栈:线程私有,存局部变量和方法调用信息,生命周期随方法,速度快但空间小,异常

StackOverflowError。 - 堆:线程共享,存对象实例,由 GC 管理,灵活但慢,异常

OutOfMemoryError。

2 抽象类 vs 接口

- 抽象类(abstract class):

- 可以包含字段、构造器、具体方法和抽象方法。

- 适用于“is-a”关系且需要共享状态或实现细节的场景。

- 单继承:类只能继承一个抽象类。

- 接口(interface):

- Java 8+ 支持

default方法、static方法;Java 9+ 支持私有方法。接口不能有实例字段(只允许public static final常量)。 - 支持多重实现(类可以实现多个接口),适合行为声明。

- Java 8+ 支持

- 语义区别:抽象类关心“什么是”,接口关心“能做什么”。

- 版本注意:由于

default方法,接口现在可以携带实现,这使得“接口演进”更容易(兼容旧实现)。

面试要点:选择抽象类还是接口的理由;接口的多继承与菱形继承问题如何解决(Java 接口方法冲突规则)。

🔹 抽象类 vs 接口:如何选择?

1. 抽象类的特点

- 可以有 成员变量(实例变量、静态变量)、构造器(但不能直接实例化)。

- 可以有 方法实现(非抽象方法)。

- 可以提供 状态 + 行为 的部分实现。

- 类只能继承一个父类 → 抽象类适合类层次结构的扩展。

👉 适用场景:

- 表达 “is-a” 关系,且有 代码复用需求。

- 子类共享一些公共逻辑,但仍需要抽象定义。

- 比如

AbstractList、HttpServlet。

2. 接口的特点

- 从 Java 8 开始,可以有 default 方法 和 static 方法(Java 9 引入 private 方法)。

- 不能有实例变量(只能有常量

public static final)。 - 用于定义 规范 / 能力(行为约定),没有状态。

- 一个类可以实现多个接口 → 更灵活。

👉 适用场景:

- 表达 “can-do” 能力,不关心类的层次结构。

- 用于跨模块、跨层的解耦(如

Serializable、Comparable、Runnable)。 - 适合 API 设计,定义一组必须实现的功能。

3. 选择准则

- 优先接口:如果只需定义行为,且希望解耦。

- 抽象类:如果需要 共享状态 或 部分实现。

- 接口 + default 方法:适合工具性扩展,不破坏已有实现。

- 抽象类 + 模板方法模式:需要控制子类实现的调用顺序。

🔹 接口的多继承 & 菱形继承问题

1. 什么是菱形继承?

比如:

1 | interface A { |

这里 D 同时继承了 B 和 C,它们都从 A 继承了 hello,并且覆盖了。

问题:D 调用 hello() 时,调用哪个?

Java 编译规则:

- 类优先 → 这里

D自己没写,父类也没有,所以走不到。 - 子接口更具体 → 但

B和C是并列接口,没有继承关系,无法判断谁更具体。 - 必须显示覆盖 → 由于有二义性,编译器直接报错,强制

D必须自己实现hello()。

2. Java 的规则(接口方法冲突解决)

Java 避免了 C++ 的“菱形继承”困境,规则如下:

- 类优先原则:

- 如果类和接口中有同名方法,优先使用类中的方法。

- 即 类 > 接口 default 方法。

- 更具体接口优先原则:

- 如果多个接口中有冲突的 default 方法,选择继承路径更“具体”的接口。

- 例:如果

B extends A,C extends A,类实现B, C→ 优先B或C的覆盖方法。

- 必须显式覆盖(冲突无法自动解决时):

- 如果继承了多个接口,且 default 方法签名冲突,必须在实现类里 显式 override。

- 可以用

X.super.method()调用指定接口的默认实现。

3. 例子:解决冲突

1 | class D implements B, C { |

🔹 面试快速答题版

- 抽象类 vs 接口:

- 抽象类:有状态(字段)、有构造器、适合类层次结构,子类共享逻辑。

- 接口:定义行为规范,无状态,可多继承,解耦性更强。

- 一般 优先接口,当需要共享实现时用抽象类。

- 接口多继承的菱形问题:

- Java 通过 明确规则避免了 C++ 菱形继承的歧义:

- 类优先于接口。

- 更具体的接口优先。

- 冲突时必须在实现类显式覆盖,并可用

X.super.method()调用。

- Java 通过 明确规则避免了 C++ 菱形继承的歧义:

3 final 关键字

- final 类:不能被继承(确保行为不可扩展/被覆盖)。

- final 方法:不能被重写(用于安全或性能提示)。

- final 变量:

- 局部 final:必须在声明或构造器/初始化块中初始化一次;在 lambda/匿名内部类中要求变量为“effectively final”。

- 成员 final(字段):在构造器中赋值后不可修改;对引用类型,final 限制的是引用不可改变,但对象状态仍可变。

- JMM 中的 final 字段语义:final 字段有特殊的内存可见性保证:构造器中写入 final 字段并且对象正确发布后,其他线程能看到正确的 final 字段值(比普通字段更强)。但安全发布仍需注意(不要在构造器中把

this逸出)。

面试点:final 与线程安全、final 与常量折叠(compile-time constant)、final 与继承/多态影响。

很好 👌 你已经把 final 的核心点 梳理得很完整了,我帮你再补充一些 细节 + 面试可能的追问点,这样遇到深挖问题也能答得很漂亮。

final 关键字总结

1. final 类

- 含义:不能被继承(例如

String,Integer,Math)。 - 设计原因:

- 确保安全性(防止子类破坏不可变性,比如

String)。 - JVM 优化(JIT 能更大胆做内联/优化,因为知道不会被 override)。

- 确保安全性(防止子类破坏不可变性,比如

- 面试追问:

- Q: 为什么

String是final?- A: 保证不可变,避免哈希缓存、字符串池等被破坏,提升线程安全。

- Q: 为什么

2. final 方法

- 含义:不能被重写(但可以被重载)。

- 用途:

- 确保某些方法的逻辑不会被子类篡改(模板方法模式常用)。

- JVM 可做早期绑定(non-virtual call),提升性能。

- 面试追问:

- Q:

private方法能否是final?- A: 可以,但没有意义,因为

private方法本来就不能被重写。

- A: 可以,但没有意义,因为

- Q:

3. final 变量

3.1 局部变量

- 必须初始化一次,之后不能改。

- lambda & 匿名类:要求变量是 effectively final(未被重新赋值即可)。

- 目的是保证闭包捕获的变量一致性。

3.2 成员变量(字段)

final字段要么在声明时初始化,要么在构造函数/初始化块中赋值。对引用类型:引用本身不能修改,但对象内容可变(浅不可变)。

1

2

3final List<String> list = new ArrayList<>();

list.add("x"); // ✅ 可行

list = new ArrayList<>(); // ❌ 不行

3.3 常量折叠

final static基本类型 +String常量 → 编译期常量,会在编译时内联。1

2public static final int A = 42;

System.out.println(A); // 编译时就替换成 42面试追问:

- Q: 如果修改了常量定义,是否需要重新编译依赖的类?

- A: 需要,否则依赖类还用旧值(因为常量折叠到字节码里)。

- Q: 如果修改了常量定义,是否需要重新编译依赖的类?

4. JMM 中的 final 语义

- 特殊内存语义:

- 构造器中对

final字段的写入,对其他线程是安全可见的(只要对象正确发布)。 - 与普通字段不同,普通字段可能出现“半初始化可见”。

- 构造器中对

- 注意点:

- 不能在构造函数中把

this逃逸(比如把自己注册到全局 map),否则final语义失效。

- 不能在构造函数中把

- 面试追问:

- Q:

final字段能完全保证不可变对象的线程安全性吗?- A: 如果对象状态完全由

final字段决定,并且没有泄漏this,是安全的。

- A: 如果对象状态完全由

- Q:

✅ 面试常见追问 + 答法

final和finally、finalize的区别?final:修饰符finally:异常处理中的保证块finalize():对象回收前调用的方法(已过时,不建议用)

final与不可变类的关系?final字段是不可变类的基础;不可变类通常要求:类是final,字段是final,且没有setter。

- 为什么 Java 要有

final字段的内存模型特殊语义?- 确保不可变对象真正安全(如

String、Integer),避免指令重排导致读到未初始化值。

- 确保不可变对象真正安全(如

4 static 关键字

- static 变量(类变量):类加载时初始化,所有实例共享。

- static 方法:与实例无关,不能直接访问非静态成员(因为没有 this)。静态方法在子类中被“隐藏”,不是多态(不能被 override,只能被子类定义同名静态方法,调用根据编译时类型)。

- static 块:类加载时执行(用于初始化复杂静态资源)。

- 静态方法能否调用非静态成员? 不能直接调用。若需要,必须先获得某个实例并通过该实例访问非静态成员。

- static synchronized:锁的是 Class 对象(

MyClass.class),而非实例。

面试点:类加载时机(静态初始化顺序)、类初始化与双亲委派、静态成员与内存泄漏(大量静态缓存)、静态方法隐藏 vs 实例方法重写。

static 关键字详解

1. static 变量(类变量)

- 生命周期:类加载时分配,JVM 在方法区(JDK8 之后是 元空间 + 堆里的静态区)为类变量分配内存。

- 共享性:所有实例共享同一份内存。

- 初始化顺序:

- 静态变量 & 静态块 → 按源码顺序依次执行。

- 在类初始化阶段完成。

- 面试追问:

- Q: 静态变量存放在哪里?

- JDK7 之前:方法区(永久代)。

- JDK8 之后:方法区 → 元空间,引用存放在元空间,实际对象可能在堆上。

- Q: 静态变量存放在哪里?

2. static 方法

特性:

- 属于类本身(Class),不依赖对象。

- 不能访问实例成员(没有

this)。 - 静态方法在子类中不会覆盖父类的静态方法,而是隐藏(Static Hiding)。

多态性区别:

1

2

3

4

5class A { static void hi() { System.out.println("A"); } }

class B extends A { static void hi() { System.out.println("B"); } }

A a = new B();

a.hi(); // 输出 A(静态绑定,取决于引用类型)面试追问:

- Q: 静态方法能否被重写?

- A: 不能,静态方法是类级别的,不走虚方法表,不具备运行时多态。

- Q: 静态方法能否被重写?

3. static 代码块

- 执行时机:类初始化时(类加载 → 验证 → 准备 → 解析 → 初始化)。

- 顺序:

- 父类静态代码块 → 子类静态代码块 → 父类构造块/构造器 → 子类构造块/构造器。

- 用途:

- 初始化复杂静态变量(如

Map、Set)。 - 加载 native 库。

- 初始化复杂静态变量(如

4. static synchronized

- 含义:锁住

Class对象。 - 区别:

synchronized实例方法 → 锁住当前对象实例 (this)。static synchronized方法 → 锁住当前类的Class对象。

- 面试追问:

- Q: 两个线程调用同一对象的实例方法(synchronized)和类方法(static synchronized),会互斥吗?

- A: 不会。因为前者锁的是实例对象,后者锁的是

Class对象。

- A: 不会。因为前者锁的是实例对象,后者锁的是

- Q: 两个线程调用同一对象的实例方法(synchronized)和类方法(static synchronized),会互斥吗?

⚡ 常见面试陷阱

❌ 1. 静态成员与内存泄漏

- 若静态变量持有对象引用(尤其是集合、缓存),会导致对象无法被 GC 回收,造成 类加载器泄漏。

- 常见于 Web 容器(Tomcat)反复部署应用。

❌ 2. 静态方法调用实例方法

1 | class Test { |

👉 必须通过实例来调用:

1 | Test t = new Test(); |

❌ 3. 静态内部类与非静态内部类

- 静态内部类:不依赖外部类实例,可以直接创建

new Outer.Inner() - 非静态内部类:需要外部类实例

new Outer().new Inner()

✅ 高频面试追问

- static 方法能否访问 this?

- 不能,因为静态方法属于类,没有 this 指针。

- 类什么时候被加载和初始化?

- 使用到静态变量/静态方法时;

- new 对象时;

- 反射调用时;

- 主类(包含

main)被启动时。

- 静态方法能否被重写?为什么?

- 不能。静态方法编译期绑定,属于类,不属于对象。子类的同名静态方法只是隐藏父类方法。

- 静态变量是否线程安全?

- 取决于是否被并发修改。

static本身只保证共享,不保证安全,仍需同步控制。

- 取决于是否被并发修改。

5 String / StringBuffer / StringBuilder

- String:

- 不可变(immutable)。任何修改都会产生新对象。好处:线程安全、可作为 Map/Set 的 key、可安全缓存(字符串常量池 intern)。

- Java 9 后内部表征从

char[]变为byte[] + coder(节省内存)。 String.intern():将字符串放到常量池,可能影响 permgen/metaspace 使用。

- StringBuffer:

- 可变字符序列,线程安全(方法使用

synchronized)。适合多线程频繁修改单一实例的场景(但通常用得少)。

- 可变字符序列,线程安全(方法使用

- StringBuilder:

- 可变字符序列,非线程安全,性能优于

StringBuffer(适合大多数单线程场景,如拼接循环中的字符串构造)。

- 可变字符序列,非线程安全,性能优于

- 容量增长:

StringBuilder的扩容策略通常为newCapacity = (oldCapacity << 1) + 2(约 2x),不同 JDK 版本细节稍有差异。

- 性能建议:大量拼接用

StringBuilder;若作为 HashMap key,用不可变String。

面试点:为什么 String 可作为 Map key(不可变性保证 hashCode 不变)、String 常量池与内存、拼接在循环里使用 + 的问题(导致大量临时 String)。

1. 为什么 String 可以作为 Map 的 key?

HashMap的 key 依赖hashCode()和equals()。- 如果 key 可变,放入后修改会导致:

- hashCode 改变 → 无法找到原来的 bucket。

- equals 改变 → 逻辑错误。

👉 String 是 不可变对象:

hashCode在第一次计算后会缓存(lazy 计算,存在hash字段里)。- 因为内容不变,hashCode 永远一致,保证放入 Map 后可以稳定检索。

equals比较基于内容,逻辑也稳定。

💡 面试点延伸:

- 为什么

String、Integer、Long等不可变对象经常作为Mapkey?

👉 因为不可变性保证了哈希一致性。

2. String 常量池与内存

字符串常量池(String Pool):

- 存放编译期确定的字面量和运行时调用

intern()的字符串。 - 在 JDK 6 以前,常量池在 永久代 (PermGen);JDK 7+ 移到 堆;JDK 8+ 完全在堆中。

- 存放编译期确定的字面量和运行时调用

工作原理:

1

2

3String s1 = "abc"; // 放入常量池

String s2 = "abc"; // 直接引用池中的同一个对象

String s3 = new String("abc"); // 在堆中创建新对象,不会自动放入池intern() 方法:

1

2String s4 = new String("abc").intern();

System.out.println(s1 == s4); // true,引用池对象

👉 好处:

- 节省内存(相同字面量只存一份)。

- 提高比较性能(字符串常量池对象可以直接用

==判断)。

3. 循环中使用 + 拼接字符串的问题

String是不可变的,每次拼接都会生成 新的对象:1

2

3

4String s = "";

for (int i = 0; i < 1000; i++) {

s = s + i; // 每次拼接都 new 一个新的 String

}内部相当于:

1

s = new StringBuilder(s).append(i).toString();

导致创建 大量临时对象,性能极差(O(n²))。

正确写法:使用

StringBuilder或StringBuffer:1

2

3

4

5StringBuilder sb = new StringBuilder();

for (int i = 0; i < 1000; i++) {

sb.append(i);

}

String s = sb.toString();

💡 面试官可能会追问:

- 为什么

"a" + "b" + "c"没问题?

👉 编译器优化,常量折叠成"abc",不会产生额外对象。 - 为什么循环里不优化?

👉 循环次数不确定,编译器无法提前合并。

4. 面试高频追问

- 为什么

String设计成不可变?- 安全性(避免泄露,例如 JDBC URL、ClassLoader 字符串)。

- 线程安全(不可变对象天然线程安全)。

- 常量池优化(相同字面量可复用)。

- 作为 HashMap key 的稳定性。

- intern() 会造成内存泄漏吗?

- JDK 6:常量池在永久代,

intern()多了可能 OOM。 - JDK 7+:移到堆中,和 GC 一起回收,不会永久泄漏。

- JDK 6:常量池在永久代,

- StringBuilder vs StringBuffer?

StringBuilder:非线程安全,单线程高性能。StringBuffer:线程安全(方法有synchronized),适合多线程环境。

✅ 简答版(面试 1 分钟答法):

String作为 Map key:不可变性保证 hashCode 和 equals 一致性。- 常量池:字符串字面量和 intern() 存在池中,节省内存,提升性能。

- 循环拼接:

+会创建大量临时对象,应使用StringBuilder。

6 == 与 equals()

- ==:

- 基本类型:比较值。

- 引用类型:比较引用地址(是否同一对象)。

- equals():

Object.equals()默认是==(引用相等)。很多类(如String、集合类、包装类)重写了equals()比较语义上的“等价性”。

- 常见陷阱:

Integer a = 127; Integer b = 127; a == b // true(因为 JVM 缓存 -128~127 范围的 Integer.valueOf);Integer x = 128; Integer y = 128; x == y // false。new String("x") == "x"为false(不同对象),但new String("x").intern() == "x"为true。

面试点:何时用 equals(内容比较),何时用 ==(引用比较);实现 equals 时遵守对称性、传递性、反射性、稳定性。

1. ==:比较引用/基本类型值

1.1 基本类型

1 | int a = 5, b = 5; |

- 对于 基本类型,

==比较的是 实际存储的值。

1.2 引用类型

1 | String s1 = new String("abc"); |

- 对于 对象引用,

==比较的是 是否指向同一内存地址(即是否同一个对象)。 - 面试常考点:

- 常量池里的字面量

String s3 = "abc"; String s4 = "abc";→s3 == s4为true(引用相同)。 new String("abc")每次创建新对象 → 引用不同。

- 常量池里的字面量

2. equals():比较内容

- 定义在

Object中:

1 | public boolean equals(Object obj) { |

- 但大多数类(如

String,Integer,List)都会重写equals(),比较对象的逻辑内容而不是引用。

1 | String s1 = new String("abc"); |

3. 使用准则

| 场景 | 使用方式 | 原因 |

|---|---|---|

| 基本类型 | == |

比较值 |

| 对象引用是否同一对象 | == |

比较内存地址 |

| 对象内容是否相同 | equals() |

比较逻辑内容,需要类正确重写 equals() |

| 容器/Map key 比较 | equals() |

Map/Set 查找时根据 equals() 决定逻辑相等 |

4. 常见面试陷阱

- String 比较:

1 | String a = "abc"; |

- 包装类比较(Integer、Long):

1 | Integer i1 = 127, i2 = 127; |

- 自定义类未重写 equals():

1 | class Person { String name; } |

- 面试点:自定义类使用内容比较需要 重写 equals()(同时重写 hashCode())。

5. 面试快捷答法

==:- 基本类型 → 值比较

- 引用类型 → 地址比较(同一个对象吗)

equals():- 内容比较(逻辑相等),前提类重写了 equals()

- 容器/Map 使用

equals()判断元素或 key 是否相等

💡 延伸小技巧:

- 写

a.equals(b)前最好检查a != null,或者用Objects.equals(a, b)防止 NullPointerException。

7 hashCode() 与 equals()

合同:

- 如果两个对象

equals()返回true,那么它们的hashCode()必须相等。 - 如果

equals()返回false,hashCode()可以相等也可以不同(哈希冲突允许)。 hashCode()在一次应用运行中应该保持稳定(对象没有修改时)。

- 如果两个对象

为什么必须重写 hashCode?

- Hash 系数据结构(

HashMap/HashSet)使用hashCode()先定位桶,再用equals()检查具体相等性。若只重写equals()而不重写hashCode(),两个逻辑相等对象可能具有不同哈希,导致放入 HashSet 后无法找到或产生重复键。

- Hash 系数据结构(

实现建议:用不可变字段计算 hash,常用

Objects.hash(...)或 IDE 生成;避免使用容易改变的字段(会导致键失效)。示例坑:

1

2

3

4

5

6class Person {

String name;

int age;

public boolean equals(Object o) { ... } // 基于 name、age

// 忘了重写 hashCode -> 在 HashSet/HashMap 中会出现问题

}

面试点:Mutable key 的危害(例如使用可变字段做 HashMap key,然后修改字段),如何设计正确的 hashCode(均匀分布、避免碰撞)。

8 包装类的自动装箱/拆箱

- 装箱(boxing):基本类型 → 对应包装类(编译器插入

Integer.valueOf(int)等)。 - 拆箱(unboxing):包装类 → 基本类型(编译器插入

intValue()等)。 - 缓存:

Integer.valueOf缓存-128 ~ 127,Boolean.valueOf缓存true/false。Long也缓存某些小值;其他包装类行为取决实现。 - 风险:

NullPointerException:Integer a = null; int b = a; // NPE。- 性能损失:频繁装拆箱会产生对象分配和 GC 压力。

==在装箱时比较的是引用(可能受缓存影响)。

- 编译例子:

Integer a = 10; int b = a + 5;→ 编译器生成int b = a.intValue() + 5;。

面试点:注意 NPE、缓存范围、避免在性能敏感路径频繁装拆箱(比如大循环中),使用原始类型或专用库(Trove、fastutil)在高性能场景下替代。

9 重载(Overload) vs 重写(Override)

- 重载(同一类或子类中):

- 同名方法,参数列表不同(参数数/类型/顺序),返回类型可不同(但仅返回类型不同不能构成重载)。

- 解析在编译时(静态绑定),基于编译时类型与参数类型选择。

- 重写(子类对父类方法):

- 方法签名完全一致(Java 8 后允许不同返回类型的协变返回),访问权限不可更严格,异常声明不能扔出新的更受检的异常。

- 调用是运行时绑定(多态)。

- 面试点:不能重写 static 方法(静态方法隐藏);不能重写 final 方法;构造器不能重写只能重载;桥接方法(bridge methods)与泛型类型擦除下的兼容。

10 Java 泛型

目的:提供编译时类型检查和更安全的代码复用。

实现机制:类型擦除(type erasure)——在编译时移除泛型信息,插入必要的类型转换和桥接方法以兼容旧字节码。

限制:

- 不能在运行时做

instanceof某个具体泛型类型(只能instanceof List)。 - 不能创建泛型数组(

new T[10]不允许)。 - 不能有泛型的静态成员直接使用类型参数(静态上下文没有类型参数信息)。

- 泛型异常(cannot create generic array of T)和不能抛出带泛型参数的受检异常。

- 不能在运行时做

通配符:

<? extends T>(生产者,只能读,PECS:Producer Extends)<? super T>(消费者,只能写,PECS:Consumer Super)

泛型方法与类型参数:

1

public static <T> T pick(T a1, T a2) { ... }

原生类型和擦除向后兼容:旧代码兼容,新代码编译会插入 casts。

面试点:PECS、类型擦除造成的桥接方法、泛型与反射(通过

Type,ParameterizedType获取泛型信息在运行时只能从声明处读取)。

1️⃣ PECS 原则(Producer Extends, Consumer Super)

概念:

针对泛型的上限、下限使用场景,由 Effective Java 提出。

公式:

? extends T→ 生产者(读取),不能写

? super T→ 消费者(写入),可以写英文记忆:PECS = Producer Extends, Consumer Super

示例:

1 | List<? extends Number> nums = new ArrayList<Integer>(); |

面试追问:

- 为什么

? extends不允许写入?- 因为具体类型可能是

Integer、Double等,写入不安全。

- 因为具体类型可能是

- 为什么

? super可以写入?- 至少可以保证写入对象是其父类类型兼容。

2️⃣ 类型擦除与桥接方法(Bridge Method)

2.1 类型擦除

- Java 泛型在编译期会被 类型擦除 → 编译后字节码不保留泛型信息(JVM 层面不支持泛型)。

- 例子:

1 | class Box<T> { |

- 编译后:

1 | class Box { |

- 编译器保证类型安全 → 泛型约束只在编译期检查。

2.2 桥接方法(Bridge Method)

- 当子类继承泛型父类或实现泛型接口时,类型擦除可能导致 方法签名不同 → 编译器生成“桥接方法”保证多态。

- 例子:

1 | class Parent<T> { |

- 编译后,JVM 方法签名:

1 | class Child extends Parent { |

- 桥接方法保证调用

Parent的引用时多态正常。

面试追问:

- Q: 为什么要生成桥接方法?

- A: 类型擦除后子类方法签名与父类不同,桥接方法保持编译期类型安全 + 运行时多态。

3️⃣ 泛型与反射

3.1 普通反射获取泛型

- 泛型类型在运行时被擦除,只能获取 声明处信息。

1 | class Box<T> { |

- 只能看到

Object,实际T已被擦除。

3.2 ParameterizedType 获取泛型信息

- 对方法、字段或类声明的泛型可以通过

Type/ParameterizedType获取:

1 | class StringBox extends Box<String> {} |

- 注意:只能获取继承/声明处的泛型,运行时对象类型信息丢失:

1 | Box<String> box = new Box<>(); |

面试追问:

- Q: 为什么

List<String>和List<Integer>在 JVM 层面是一样的?- A: 泛型擦除,运行时都是

List,类型信息只在编译期存在。

- A: 泛型擦除,运行时都是

4️⃣ 面试答题模板

- PECS 原则:

? extends T→ 生产者,读取安全,写入不安全? super T→ 消费者,可写入,读取只能当 Object

- 类型擦除:

- 泛型信息在编译期检查,运行期擦除成原始类型。

- 编译器通过桥接方法保持多态和类型安全

- 反射获取泛型:

- 只能读取 声明处类型

Type/ParameterizedType→ 获取具体泛型类型- 运行期对象泛型类型丢失

💡 小技巧面试答法:

- 提到桥接方法和类型擦除时,可以画一条箭头:

Parent<T>→Child extends Parent<String>→ 编译器生成桥接方法 → JVM 方法签名多态保持一致

11 反射

作用:在运行时加载类、查看结构(字段/方法/构造器)、动态调用方法/访问字段、创建对象。

核心 API:

Class<?>、Field、Method、Constructor、Annotation。常见用法:框架(Spring/ORMs)、测试工具、序列化库、动态代理。

性能与安全:

- 反射调用速度比直接调用慢很多(因为涉及安全检查、解析),可以通过

setAccessible(true)跳过访问检查来提高性能(但 Java 9 的模块化和安全策略会限制)。 - 替代方案:

MethodHandle/invokeWithArguments(更快),或者生成字节码(ASM)/动态代理。

- 反射调用速度比直接调用慢很多(因为涉及安全检查、解析),可以通过

访问私有成员:

field.setAccessible(true)(受 Java 模块化与安全管理器影响)。面试点:反射的用途与成本、如何用反射实现依赖注入、

Class.forName()与类加载器、类加载器三层结构与资源隔离。

1️⃣ 反射的用途

反射是 Java 动态获取类/对象信息、动态调用方法的机制。常用用途:

- 动态创建对象

1 | Class<?> clazz = Class.forName("com.example.User"); |

- 动态获取/修改属性

1 | Field f = clazz.getDeclaredField("name"); |

- 动态调用方法

1 | Method m = clazz.getMethod("sayHello", String.class); |

- 实现依赖注入(DI)和 IoC

- 框架在运行时扫描类,自动实例化对象、注入依赖(Spring、Guice 原理)。

- 思路:

- 扫描类路径,找到带注解的类。

- 通过

Class.newInstance()或getDeclaredConstructor().newInstance()创建实例。 - 使用

Field.set()注入依赖对象。

1 | class UserService { |

- Spring 实现:

- 利用

ReflectionUtils设置私有字段可访问 - 注入 bean,实现松耦合

- 利用

2️⃣ 反射的成本

- 性能开销

- 方法调用绕过静态类型检查 → JVM 无法内联优化 → 相比普通方法慢 10~20 倍

- 访问私有成员需要

setAccessible(true)→ 打破 JIT 优化

- 安全问题

- 可访问私有字段和方法 → 可能破坏封装

- 需要

SecurityManager或模块系统权限限制

- 可维护性

- 编译期无法检查成员存在 → 容易出错

- 不利于重构

总结:反射强大但开销大、可读性差,一般用于框架层、工具类或动态代理,不适合业务频繁调用。

3️⃣ Class.forName() 与类加载器

Class.forName(String className)作用:加载指定类,执行静态初始化块(类初始化阶段)

常用在 JDBC:

1

Class.forName("com.mysql.jdbc.Driver");

对比:

1

2Class<MyClass> clazz = MyClass.class; // 不触发初始化

Class.forName("MyClass"); // 会初始化类

类加载器

- ClassLoader:负责加载

.class字节码 → JVM 在内存生成Class对象 - 核心方法:

loadClass()→ 只加载,不初始化defineClass()→ 将字节码转换成 Class 对象- 初始化阶段触发静态块

4️⃣ 类加载器三层结构与资源隔离

Java 类加载器采用 父委托模型(Parent Delegation Model),常见三层:

| 层级 | 典型实现 | 加载范围 | 面试要点 |

|---|---|---|---|

| Bootstrap(启动类加载器) | JVM 内置 | java.* |

加载核心类库,无法直接获取对象 |

| Extension(扩展类加载器 / Platform) | sun.misc.Launcher$ExtClassLoader |

jre/lib/ext |

加载扩展类库 |

| Application(系统类加载器 / AppClassLoader) | 默认 | classpath 下应用类 | 加载业务代码和第三方依赖 |

- 父委托原则:

- 子加载器先委托父加载器

- 避免类被重复加载,保证核心类安全性

- 资源隔离:

- 不同类加载器加载同名类是不同

Class对象(内存隔离) - 典型应用:Web 容器(Tomcat)每个 webapp 一个类加载器 → 防止类冲突和资源泄漏

- 不同类加载器加载同名类是不同

5️⃣ 面试追问

- 反射能调用 private 方法吗?

- ✅ 可以,使用

setAccessible(true),破坏封装,但有安全风险。

- ✅ 可以,使用

- 为什么 Class.forName() 要抛 ClassNotFoundException?

- 因为指定的类可能不存在,加载失败时必须捕获异常。

- 为什么不同类加载器加载同名类是不同类型?

- JVM 内存中

Class对象由 类加载器 + 类全限定名 唯一确定 → 同名不同加载器,视为不同类。

- JVM 内存中

- 反射创建对象和直接 new 的性能差异?

- 反射慢 10~20 倍,主要因为动态解析、绕过 JIT 优化。

✅ 快速答题模板(面试版):

- 反射用途:动态创建对象、获取/修改属性、调用方法 → 框架 DI/IoC 核心

- 反射成本:性能慢、破坏封装、安全风险、可维护性低

- 依赖注入:扫描类 + newInstance() + Field.set()

- Class.forName():加载类并初始化

- 类加载器三层:

- Bootstrap → 核心类

- Extension → 扩展类

- App → 应用类

- 父委托 + 资源隔离:

- 避免类重复加载,Web 容器隔离每个应用,防止冲突

1️⃣ 双亲委派(Parent Delegation Model)

核心思想:

- 类加载请求先交给父类加载器,父加载器无法加载时才由子加载器自己加载。

- 保证核心类由 Bootstrap ClassLoader 加载,避免重复加载或安全问题。

加载流程:

- 子加载器收到加载请求(比如 AppClassLoader)

- 委托给父加载器(ExtClassLoader)

- 父加载器继续委托给更上层(Bootstrap)

- Bootstrap 能加载 → 返回 Class 对象

- 父加载器无法加载 → 子加载器自己加载

特点:

- 防止核心类被篡改(例如

java.lang.String永远由 Bootstrap 加载) - 保证每个类在 JVM 中唯一(Class+ClassLoader 唯一标识)

12 线程安全的集合与使用

- 同步封装(JDK Collections 工厂):

Collections.synchronizedList/Map/Set(...):把单个操作同步化(方法级锁)。注意:复合操作(check-then-act)仍需外部同步。

- 并发集合(java.util.concurrent):

ConcurrentHashMap:高并发哈希表(JDK8 以 CAS + synchronized on bin 为主)。putIfAbsent,remove(key, val),replace等原子操作。迭代弱一致(weakly consistent),不会抛 ConcurrentModificationException。CopyOnWriteArrayList/CopyOnWriteArraySet:写时复制,读多写少场景优秀(读无需锁,写创建新数组)。BlockingQueue(见第 22 题)用于生产者-消费者。ConcurrentLinkedQueue(无界非阻塞队列),基于 CAS 的链表。

- 如何使用:

ConcurrentHashMap适合频繁并发读写:使用computeIfAbsent避免 check-then-put race。- 对于复杂事务性操作,使用外部锁或事务机制;不要依赖单个集合的同步保证跨多个集合的一致性。

面试点:为什么 Collections.synchronizedMap 不能完全替代 ConcurrentHashMap(并发粒度和性能差别);CopyOnWrite 的开销与适用场景。

13 HashMap 底层原理与扩容机制

- 主要数据结构:数组(

Node<K,V>[] table) + 单向链表(发生哈希冲突时) + 当单条链表长度超过阈值时转为红黑树(TreeNode)。 - 重要常量(JDK8):

DEFAULT_INITIAL_CAPACITY = 1 << 4(16)MAXIMUM_CAPACITY = 1 << 30TREEIFY_THRESHOLD = 8(链表长度超过 8 时考虑树化)UNTREEIFY_THRESHOLD = 6(树退回链表阈值)MIN_TREEIFY_CAPACITY = 64(只有当 table 长度 >= 64 时才树化,否则先扩容)DEFAULT_LOAD_FACTOR = 0.75f(负载因子)

- hash 计算:

static final int hash(Object key) { int h; return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16); }- 通过高位与低位混合(扰动)减小冲突(高位影响到低位)。

- 索引计算:

index = (n - 1) & hash(利用容量为2的幂使位运算快速定位)。 - put 操作流程:

- 若 table 为 null,先初始化(默认容量 16)。

- 计算 hash、定位 bucket。

- 若 bucket 为空,直接插入(用 CAS 在并发场景未锁定时也能操作)。

- 若不为空,遍历链表或树:若发现 key 相等,覆盖 value;否则追加到链表尾或在树中插入。

- 若链表长度超过 TREEIFY_THRESHOLD 并且 table 长度 >= MIN_TREEIFY_CAPACITY,则树化;否则触发 resize。

- 每次插入后检查

size > threshold(threshold = capacity * loadFactor),超出则触发扩容。

- 扩容(resize):

- 扩容为 2 倍(

newCap = oldCap << 1),计算新阈值newThr = oldThr << 1。 - JDK8 中 resize 会把旧链表拆分为两个链表(low 和 high),利用节点 hash 与 oldCap 的单个位判断新索引,避免完全重新计算哈希。

- 扩容成本高(rehash),会导致短暂性能抖动;并发扩容会带来线程安全问题(HashMap 在并发写时可能造成链表成环导致 CPU 100% 等问题,故 HashMap 不是线程安全 的)。

- 扩容为 2 倍(

- get 操作复杂度:平均 O(1),最坏在所有元素冲突为同一槽且未树化时 O(n),JDK8 树化后降为 O(log n)。

面试点/常考题:

HashMap 的扩容触发条件与默认容量;为什么使用负载因子;为什么选择 0.75(时间/空间折中)。

为何要树化,何时树化(避免 O(n) 退化)。

在并发写入下 HashMap 会出现什么问题(死循环/链表环),以及解决方式(使用 ConcurrentHashMap 或外部同步)。

HashMap key 应该不可变,否则查找会出问题(例如 key 的 hashCode 依赖可变字段被修改后找不到)。

1️⃣ HashMap 扩容与负载因子

1.1 扩容触发条件

默认初始容量:16(2 的幂)

默认负载因子:0.75

触发条件:

1

当 size > capacity * loadFactor 时,触发扩容

- size:当前元素个数

- capacity:当前 table 长度

扩容通常 容量翻倍(2 倍)

1.2 为什么使用负载因子?

- 控制 HashMap 空间利用率与查找性能的折中。

- 负载因子过小:

- table 空间浪费严重

- 扩容频繁 → 性能开销大

- 负载因子过大:

- 链表长度增加 → 查找效率降低

- 0.75 的理由:

- Java 官方选择 0.75 作为折中点

- 平均查找 O(1),空间利用率较高

2️⃣ 为什么要树化(红黑树)

2.1 问题背景

- JDK8 前 HashMap 使用链表存储哈希冲突

- 当哈希碰撞严重,链表长度达到 O(n),查找退化成 O(n)

2.2 树化规则

- 当链表长度 > TREEIFY_THRESHOLD = 8 且数组长度 >= MIN_TREEIFY_CAPACITY = 64

- 链表会转为 红黑树

- 查找、插入、删除 → O(log n)

2.3 面试追问

- 为什么加数组长度限制(MIN_TREEIFY_CAPACITY)?

- 小数组直接扩容比树化更划算

- 为什么红黑树而不是 AVL 树?

- 红黑树插入删除调整成本低,适合哈希表冲突场景

3️⃣ HashMap 并发写入问题

3.1 并发问题表现

- JDK8 前:

- 多线程 put 时链表可能形成环 →

get()死循环

- 多线程 put 时链表可能形成环 →

- JDK8+:

- 仍不保证线程安全 → 写入可能丢失或覆盖

3.2 解决方式

使用 ConcurrentHashMap → 分段锁(JDK7)或 CAS + synchronized(JDK8+),线程安全

外部同步:

1

Map<K,V> map = Collections.synchronizedMap(new HashMap<>());

禁止在多线程下直接操作 HashMap

4️⃣ HashMap key 应该不可变

4.1 原因

key 的 hashCode 和 equals 必须稳定

如果 key 可变:

1

2

3

4

5Map<Person, String> map = new HashMap<>();

Person p = new Person("Tom");

map.put(p, "data");

p.setName("Jerry"); // hashCode 改变

map.get(p); // 返回 null,找不到原 keyHashMap 查找依赖 hashCode → bucket → equals

4.2 面试追问

- 可变 key 可以做什么防护?

- 不允许修改关键字段

- 使用不可变类(String、Integer、UUID)

- 或重新 put/update map

5️⃣ 面试快速答题模板

- 扩容

- 默认容量 16,负载因子 0.75 → 触发扩容

- 0.75 是时间/空间折中

- 树化

- 链表长度 > 8 且容量 >= 64 → 红黑树

- 提高查找性能,避免 O(n)

- 并发写入

- 多线程 HashMap 可能死循环/数据丢失

- 解决:ConcurrentHashMap 或外部同步

- key 不可变

- hashCode/equals 稳定 → 确保 put/get 正确

💡 补充底层知识点

扩容时 rehash:每个元素都需要重新计算桶索引

hash 再扰动:

为了减少高位相同导致冲突,JDK8 对 hash 做扰动处理:

1

2

3

4static final int hash(Object key) {

int h;

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

链表转树条件:

- 链表太长 → 树化

- 树节点太少 → 链表化(UNTREEIFY_THRESHOLD = 6)

14 ConcurrentHashMap 的线程安全实现(深入,JDK7 vs JDK8)

- JDK7(老的实现):

- 基于分段锁(

Segment[] segments),每个 Segment 维护一把锁,锁的粒度为 segment(可并行度 = segment 数);操作在单个 segment 内并发安全。

- 基于分段锁(

- JDK8(重构后的实现):

- 去掉 Segment,使用与 HashMap 类似的

Node<K,V>[] table。 - 无全表锁:采用多种优化——CAS 创建节点/置入、synchronized 仅在单个 bin 上(链表或 tree bin 上)用于插入/修改,读取操作不加锁(volatile 可见)。

- 关键概念:

table是 volatile,节点next、value等字段使用 volatile/CAS,以保证可见性和原子性。put:先 CAS 尝试把新 node 放到空桶;若失败或桶非空,采用 synchronized(binHead) 来完成插入(以避免竞争)。putIfAbsent、computeIfAbsent等使用 CAS + 锁配合来保证原子性。- 树化:当单个 bucket 链表长度过大时,会转为树(与 HashMap 类似)。

- 扩容:采用多线程协助搬迁(transfer),

sizeCtl字段控制迁移状态,多个线程可以参与一次扩容以提升效率。

- 读取:

get通常是无锁的,遍历链表或 tree bin,用 volatile 读取确保可见。

- 去掉 Segment,使用与 HashMap 类似的

- 弱一致性迭代:迭代器不会抛出

ConcurrentModificationException,返回的是“弱一致”视图(可能看不到一些并发修改,也可能看到)。 - 性能:JDK8 的实现综合使用 CAS 和局部锁,读性能非常好,写性能也较 JDK7 改进。

面试点:ConcurrentHashMap 为什么不需要全局锁,get 为什么不加锁安全,为什么 remove/size 等操作不是常 O(1) 精确(需要并发统计)。

1️⃣ 为什么 ConcurrentHashMap 不需要全局锁?

1.1 JDK 7 vs JDK 8

| 版本 | 锁机制 |

|---|---|

| JDK 7 | 分段锁(Segment + ReentrantLock) |

| JDK 8+ | Node + CAS + synchronized(链表/红黑树节点) |

1.2 核心思想

- 细粒度锁,只锁某个桶(bucket)或链表节点,而不是整个表

- CAS(Compare-And-Swap)+ synchronized:大部分操作通过 CAS 保证原子更新,链表/树节点操作用局部锁

- 结果:并发写入多个桶时不会互相阻塞 → 高吞吐量

2️⃣ 为什么 get 不加锁也安全?

2.1 原理

- volatile + final 保证可见性

- HashMap table、Node.value 都是 volatile 或 final → 线程读取总能看到最新对象

- 读取操作不修改结构

get()只是按 hash 找到 bucket,再遍历链表/红黑树读取 value → 不改变链表结构

- JMM 保证可见性

- 写入操作(put/resize)保证 happens-before → get 读取安全

2.2 面试要点

- get 不加锁 → 高性能,线程安全

- 注意:

- 遍历过程中,写入可能正在进行 → 可能 get 不到最新数据,但不会抛异常

3️⃣ remove/size 等操作为什么不是 O(1) 精确?

3.1 remove

- remove 需要找到对应桶,再修改链表/树节点

- 对每个桶局部加锁,不同线程可能同时删除 → 最终结果仍正确

- 不是全局锁 → 并发 remove 与 put/resize 会交错,复杂度取决于链表长度(O(n/k))

3.2 size()

- ConcurrentHashMap 不维护全局计数器

- 各个桶独立统计 size → 获取精确值需要遍历所有桶并累加

- 在高并发情况下,size() 可能 瞬间不精确

- 避免频繁全局锁 → 提升性能

- 如果需要精确 size,可以用

mappingCount()或外部同步

4️⃣ 面试答题模板

- 不需要全局锁

- JDK8 使用 CAS + synchronized(局部桶锁)

- 写操作只锁部分桶 → 高并发性能

- get 不加锁安全

- Node.value/next 是 volatile/final → 线程可见性

- 读取不修改结构 → 不会破坏链表/树

- remove/size 非 O(1)

- remove → 需要遍历桶 → 复杂度取决于链表长度

- size → 各桶统计,不加全局锁 → 可能瞬间不精确

- 总结

- 高性能 → get 无锁

- 写入局部锁 → 避免全局阻塞

- size/remove 不保证严格 O(1) → 设计折中性能和精确性

💡 补充知识点

- JDK8 table resize:使用

ForwardingNode+ CAS,保证扩容期间并发安全 - 红黑树/链表转换:在并发环境下用 synchronized 保证线程安全

- volatile 语义:

- 避免部分线程看到旧值

- 保证 Node 节点读写顺序

15 ArrayList vs LinkedList

- ArrayList:

- 内部是动态数组(

Object[] elementData)。 - 随机访问

get(i)为 O(1)。 - 插入/删除在尾部 amortized O(1);在中间位置插入/删除需要移动元素 O(n)。

- 扩容策略:默认初始为空数组(jdk8之后),第一次 add 会扩容到 10;后续扩容

newCapacity = old + (old >> 1)(约 1.5x)。 - 内存紧凑,良好缓存局部性(CPU cache 友好)。

- 内部是动态数组(

- LinkedList:

- 基于双向链表(

Node包含 prev/next/item)。 - 随机访问

get(i)为 O(n)(需要顺序遍历)。 - 在列表中间插入/删除为 O(1)(仅修改邻接节点指针),前提是已定位到节点(定位本身 O(n))。

- 内存占用高(每个节点多个指针对象),GC 压力更大。

- 基于双向链表(

- 选择准则:

- 频繁随机访问 →

ArrayList。 - 频繁在列表中间插入/删除且遍历更多 →

LinkedList(但在多数场景ArrayList仍优,因为插入删除远不如随机访问常见,而且复制成本在局部更低)。

- 频繁随机访问 →

面试点:扩容开销、ensureCapacity、trimToSize、迭代时的 fail-fast(modCount)机制。

1️⃣ 扩容开销

1.1 扩容触发条件

ArrayList 内部用

Object[] elementData存储元素触发条件:

1

size >= elementData.length

默认容量:

- 初始容量:10(无参构造)

- 构造器可指定初始容量

ArrayList(int initialCapacity)

1.2 扩容机制

- 扩容时通常 1.5 倍或 2 倍(JDK 8 ArrayList 为 1.5 倍)

- 扩容开销:

- 新数组分配 → O(n)

- 旧数组元素复制 → O(n)

- 面试追问:

- 批量插入大量元素时最好指定初始容量 → 避免多次扩容

2️⃣ ensureCapacity(int minCapacity)

2.1 作用

- 手动确保 ArrayList 至少有

minCapacity容量 - 提前分配数组 → 避免频繁扩容

2.2 使用示例

1 | ArrayList<Integer> list = new ArrayList<>(); |

2.3 面试点

- 用于性能优化

- 避免批量添加时不断触发扩容和数组复制

3️⃣ trimToSize()

3.1 作用

- 将

elementData数组容量缩减到 当前 size - 节约内存空间,特别是 ArrayList 元素较少且容量大时

3.2 使用示例

1 | ArrayList<Integer> list = new ArrayList<>(1000); |

3.3 面试点

- 用于 内存优化

- 注意:之后再次 add 元素可能触发扩容 → 有性能开销

4️⃣ 迭代时的 fail-fast(modCount)机制

4.1 原理

ArrayList 内部维护

modCount:- 每次 结构性修改(add/remove/clear) → modCount++

Iterator 获取 modCount 副本

expectedModCount遍历时检查:

1

2if (modCount != expectedModCount)

throw new ConcurrentModificationException();

4.2 触发场景

- 结构性修改 → 抛 ConcurrentModificationException

- 非结构性修改(如

set()替换元素)不会触发

4.3 面试点

- 目的:快速发现并发或不安全操作 → fail-fast

- 注意:

- 并发修改 ArrayList → Iterator 异常

- 并发安全 → 使用

CopyOnWriteArrayList或手动同步

5️⃣ 面试快速答题模板

- 扩容开销

- 扩容触发条件:

size >= capacity - 扩容过程:新数组 + 元素复制 → O(n)

- 优化:指定初始容量

- 扩容触发条件:

- ensureCapacity

- 提前分配容量,避免频繁扩容

- trimToSize

- 缩减数组长度到当前 size → 节约内存

- fail-fast

modCount记录结构性修改- Iterator 检查

expectedModCount - 结构修改 →

ConcurrentModificationException

💡 补充知识点

- ArrayList 扩容策略是 时间/空间折中

- 迭代器 fail-fast 并非严格同步机制 → 只是快速失败检测

- 批量插入 + ensureCapacity → 性能最佳实践

1️⃣ LinkedList 基本原理

底层结构:双向链表(Doubly Linked List)

1

Node<E> { E item; Node<E> next; Node<E> prev; }

存储特点:

- 每个节点包含元素值 + 前驱 + 后继指针

- 内存分配按节点动态分配(Heap)

- 不需要预分配容量 → 没有扩容概念

特点:

- 增删快:O(1)(已定位节点时)

- 查找慢:O(n)(按索引遍历节点)

- 支持双向遍历:prev/next

2️⃣ 插入与删除

- add / addFirst / addLast

- 创建新节点 → 更新前驱/后继 → size++

- 已知节点可在 O(1) 完成插入

- remove / removeFirst / removeLast

- 更新前驱/后继指针 → GC 回收节点 → size–

- 按索引插入/删除

- 需遍历节点 → O(n)

面试点

- 插入删除头尾快,随机访问慢

- 对比 ArrayList:随机访问慢,尾部插入快或慢取决于是否扩容

3️⃣ 迭代器与 fail-fast

modCount 机制与 ArrayList 类似

- LinkedList 每次结构修改(add/remove/clear) →

modCount++

- LinkedList 每次结构修改(add/remove/clear) →

迭代器

创建时记录

expectedModCount = modCountnext()/remove() 时检查:

1

if (modCount != expectedModCount) throw new ConcurrentModificationException();

特点

- 遍历链表时结构修改 → fail-fast

- 非结构性修改(修改元素值

set())不触发异常

4️⃣ LinkedList 特点总结

| 特性 | LinkedList | ArrayList |

|---|---|---|

| 底层结构 | 双向链表 | 动态数组 |

| 随机访问 | O(n) | O(1) |

| 插入/删除 | O(1) 已知节点 | O(n) 平均 |

| 内存分配 | 节点动态分配 | 整体数组扩容(复制元素) |

| 迭代器 | fail-fast | fail-fast |

| 扩容 | 不需要 | 需要复制数组(O(n)) |

| 内存开销 | 大,每个节点多 2 个指针 | 小,连续内存 |

5️⃣ 面试追问

- LinkedList 和 ArrayList 何时用哪个?

- ArrayList:随机访问多,插入删除少

- LinkedList:频繁插入/删除头尾,随机访问少

- 为什么 LinkedList 没有扩容?

- 每个节点单独分配,链表不需要连续内存 → 不存在数组复制开销

- fail-fast 能保证并发安全吗?

- ❌ 不能,只是快速失败检测

- 并发操作需外部同步或使用

CopyOnWriteArrayList/ConcurrentLinkedDeque

- 为什么 LinkedList 内存占用大?

- 每个节点额外保存两个引用(prev/next)

- 对象头 + 数据 + 两个引用 → 比 ArrayList 每元素占用多

6️⃣ 面试快速答题模板

- 底层:双向链表 → 每节点:item/prev/next

- 扩容:无,动态分配节点

- 增删:头尾 O(1),随机 O(n)

- 迭代器:fail-fast,通过 modCount 检测结构修改

- 适用场景:频繁插入/删除,顺序遍历;随机访问少

- 内存开销:比 ArrayList 高(节点指针多)

💡 补充知识点

- Java 8 LinkedList 内部节点还是

Node<E>+ 双向链表 - 支持 Deque 接口 → 可以用作栈/队列

- fail-fast 和多线程并发同样不安全 → 外部同步或使用

ConcurrentLinkedDeque

16 基本类型 vs 包装类型

- 基本类型:

- 存放值,效率高,不能为

null。 - 不能用于泛型(必须使用包装类),不能放入集合(需要装箱)。

- 存放值,效率高,不能为

- 包装类型(如 Integer):

- 对象,存放在堆,有对象头,有引用开销,支持

null。 - 提供方法(parse、valueOf 等)。

- 对象,存放在堆,有对象头,有引用开销,支持

- 性能差异:包装类型会产生额外对象分配与 GC,尽量在性能敏感场景使用基本类型数组(

int[])或原语流/第三方库。

17 Java 的 Object 类常用方法

equals(Object obj):比较逻辑相等。hashCode():哈希码。toString():字符串表示。getClass():返回运行时 Class 对象。clone():浅拷贝(需实现Cloneable才有效,通常不推荐使用 clone)。finalize():对象回收前调用(已弃用,不可靠,JDK9+ 标记为 deprecated)。wait()/notify()/notifyAll():对象监视器(必须在 synchronized 块中调用),用于线程间通信。registerNatives()等(本地方法)。

面试点:为什么不建议使用 finalize;如何正确使用 wait/notify(必须在同步块中,防止虚假唤醒用 while 循环判断 condition)。

好的,wait/notify 是 Java 多线程协作的核心面试点,常被问“为什么必须在同步块中”、“虚假唤醒如何处理”,我帮你系统整理,并给出例子。

1️⃣ wait/notify 基本原理

- wait()

- 让当前线程进入等待状态,释放持有的锁

- 等待其他线程调用

notify()或notifyAll()唤醒 - 必须在 同步块/方法中调用,否则抛

IllegalMonitorStateException

- notify() / notifyAll()

- 唤醒在当前对象 monitor 上等待的线程

- notify:随机唤醒一个

- notifyAll:唤醒所有线程

2️⃣ 必须在同步块中的原因

每个对象有 对象监视器(monitor)

wait/notify操作依赖持有 monitorJava 语言规定:

1

2

3

4monitor.enter(); // synchronized

wait() // 释放 monitor,进入等待队列

notify() // 唤醒等待队列线程

monitor.exit();

3️⃣ 防止虚假唤醒

虚假唤醒:线程可能被唤醒,但条件不满足

因此 wait 必须放在 while 循环中检查条件:

1

2

3

4

5

6synchronized(lock) {

while (!condition) {

lock.wait();

}

// 条件满足,执行任务

}不要用 if,因为虚假唤醒或多线程唤醒可能导致错误执行

4️⃣ wait/notify 使用模板

1 | class Resource { |

- 特点:

- 条件检查放在

while中 → 防虚假唤醒 wait/notifyAll都在 synchronized 方法或块 中notifyAll通常比notify更安全,避免某些线程永远等待

- 条件检查放在

5️⃣ 示例:生产者-消费者

1 | public class ProducerConsumerDemo { |

输出示意:

1 | Producing... |

- 生产者和消费者轮流执行

while循环保证虚假唤醒时线程不会错误执行- synchronized + wait/notifyAll 保证线程安全

✅ 面试要点总结

- 必须在同步块中 → 持有对象 monitor

- 防止虚假唤醒 →

while(condition) - notify vs notifyAll

- notify 唤醒一个线程,效率高,但可能导致线程饿死

- notifyAll 唤醒所有线程,更安全

- 线程安全协作

- wait 释放锁 → allow 其他线程执行

- 条件改变后 notifyAll 唤醒等待线程

18 深拷贝 / 浅拷贝 / 引用拷贝

- 引用拷贝:变量复制引用,两者指向同一对象(

a = b)。 - 浅拷贝:

- 对象本身复制一份(字段为基本类型复制值),引用类型字段复制引用(不复制引用对象)。

Object.clone()默认实现就是浅拷贝(只复制字段)。

- 深拷贝:

- 不仅复制对象本身,还递归复制所有引用对象(或复制所需的子对象),得到完全独立的对象树。

- 实现方式:手写递归复制、通过序列化(对象->字节->对象)或使用第三方库(如 Apache Commons Lang

SerializationUtils.clone())/手动 copy constructor。

- 面试点:浅拷贝带来的共享可变子对象问题;clone 的陷阱(浅拷贝导致共享、需要实现 Cloneable 并覆盖 clone、异常处理);如何实现可扩展的深拷贝(每个类提供 copy constructor 或工厂方法)。

19 JDK 动态代理 & CGLIB

JDK 动态代理(java.lang.reflect.Proxy):

基于接口:只能为实现了接口的类创建代理。

通过

InvocationHandler的invoke(Object proxy, Method method, Object[] args)拦截所有方法调用。代码示例:

1

2

3

4

5MyInterface proxy = (MyInterface) Proxy.newProxyInstance(

loader,

new Class<?>[]{MyInterface.class},

(p, m, a) -> { /* 横切逻辑 */ return m.invoke(target, a); }

);

CGLIB(字节码生成, org.springframework.cglib 或 net.sf.cglib):

- 基于生成目标类的子类(继承)并重写方法,适用于没有接口的类。

- 不能为

final类或final方法创建代理(因为继承时无法覆盖 final 方法)。

Spring AOP:默认使用 JDK 动态代理(若目标实现接口),否则回退到 CGLIB(或可强制使用 CGLIB)。

性能:JDK Proxy 在接口较多时开销较小,CGLIB 在没有接口的情况下是必须选项;现代实现都很快,但生成字节码开销存在(通常在代理创建时发生一次)。

面试点:自调用(同类方法内部调用)不会触发通过代理的拦截(因为代理是外部包装);如何绕开(用 AopContext.currentProxy() 或把逻辑放到另一个 bean)。

20 序列化 / 反序列化

序列化:将对象转成字节流(保存到文件/传输网络)。

反序列化:字节流还原为对象。

Java 原生序列化:

- 对象需实现

Serializable。可以定义private static final long serialVersionUID控制版本兼容。 - 可标

transient字段为不序列化。 - 缺点:体积大、性能差、安全风险(直接反序列化恶意数据存在 RCE 风险),版本兼容复杂。

- 对象需实现

替代协议:Protobuf、Avro、Thrift、Kryo、Hessian、JSON 等(更紧凑/跨语言/更安全)。

面试点:serialVersionUID 作用、如何实现自定义序列化(

writeObject/readObject)、安全问题与防御(不要直接反序列化不可信数据、使用白名单、安全库)。

1️⃣ serialVersionUID 作用

- 定义:

private static final long serialVersionUID - 用途:序列化时标识类版本

- 工作原理:

- 序列化对象 → 在字节流中写入

serialVersionUID - 反序列化 → JVM 检查流中

serialVersionUID与本地类是否匹配 - 不匹配 → 抛

InvalidClassException

- 序列化对象 → 在字节流中写入

- 默认行为:

- 如果没有显式声明,JVM 会根据类结构自动生成 UID

- 类结构变更 → UID 变更 → 反序列化失败

- 面试答题重点:

- 显式声明

serialVersionUID→ 保证类结构轻微变动后仍能兼容 - 推荐所有可序列化类都显式声明

- 显式声明

1 | private static final long serialVersionUID = 1L; |

2️⃣ 自定义序列化

- 默认实现:

ObjectOutputStream.writeObject()→ 按字段顺序写入ObjectInputStream.readObject()→ 按字段顺序读取

- 自定义:通过实现

writeObject/readObject方法

2.1 示例

1 | import java.io.*; |

- 特点:

defaultWriteObject()/defaultReadObject()→ 保留默认序列化- 可自定义处理 transient 或敏感字段

- 可以做数据加密、压缩或版本兼容处理

3️⃣ 安全问题

3.1 常见问题

- 反序列化不可信数据

- 攻击者可以构造恶意对象 → 触发任意代码执行

- 典型 CVE:

CommonsCollections反序列化链攻击

- 对象注入

- 构造特殊 payload → 修改程序行为、执行任意方法

3.2 防御措施

避免直接反序列化外部数据

1

2ObjectInputStream ois = new ObjectInputStream(socket.getInputStream());

Object obj = ois.readObject(); // 危险- 尽量使用 安全库 或 数据转换格式(JSON、Protobuf)

白名单机制

JDK 9+ 提供

ObjectInputFilter:1

2ObjectInputFilter filter = ObjectInputFilter.Config.createFilter("java.base/*;!*");

ois.setObjectInputFilter(filter);只允许特定类反序列化,拒绝未知类

自定义 readObject() 验证数据

- 检查字段合法性、防止恶意 payload

序列化替代方案

- JSON、Protobuf、Kryo(安全配置)

4️⃣ 面试答题模板

- serialVersionUID

- 标识类版本

- 显式声明避免类结构改动破坏兼容

- 自定义序列化

writeObject/readObject- 处理 transient / 加密 / 压缩 / 版本兼容

- 安全问题

- 不可信数据反序列化 → 可执行任意代码

- 防御:白名单、过滤器、自定义验证、使用安全库

- 最佳实践

- 所有 Serializable 类显式声明 UID

- 避免直接反序列化外部输入

- 对敏感数据用 transient + 自定义序列化处理

💡 补充知识点

readResolve()/writeReplace()→ 允许序列化替换对象- 反序列化安全是高频面试点 → 尤其是 Java 企业安全岗

21 常见序列化协议(优缺点)

- Java 原生:易用但臃肿、慢、安全问题。

- JSON(Jackson / Gson):可读、跨语言、慢于二进制、无模式(schema)。

- Protobuf(Google):二进制、高效、需要 schema、跨语言。

- Avro:支持 schema 演进,适合大数据。

- Thrift:类似 Protobuf,支持 RPC。

- Kryo:高性能 Java 专用序列化(用于低延迟场景)。

- Hessian:二进制 Web 服务序列化,跨语言。

面试点:如何基于场景(跨语言/性能/兼容性)选择序列化协议。

22 BlockingQueue

- 定义:

BlockingQueue支持在队列为空时阻塞消费者;在队列为满时阻塞生产者。常用于生产者-消费者模式,线程池的 work queue。 - 方法:

- 阻塞:

put(E)(满时阻塞)、take()(空时阻塞)。 - 非阻塞:

offer(E)、poll()(可返回 null 或布尔)。 - 带超时:

offer(E, timeout, unit)/poll(timeout, unit)。

- 阻塞:

- 常见实现:

ArrayBlockingQueue:基于数组、固定大小、可选择公平/非公平锁(ReentrantLock)实现。LinkedBlockingQueue:基于链表,可选边界(默认 Integer.MAX_VALUE),读写使用不同锁,吞吐量高。PriorityBlockingQueue:基于优先队列,不保证 FIFO,非公平(无阻塞 put,因为无界)。SynchronousQueue:不保存元素,每个 put 必须等待一个 take(直接交付)。适合线程间直连交互(常用在 ForkJoinPool,或 ThreadPoolExecutor 饱和策略)。DelayQueue:元素带延迟,只有到期后才能被 take(常用于定时任务)。

- 使用建议:根据吞吐与公平性选择实现;

LinkedBlockingQueue适合高吞吐,ArrayBlockingQueue提供固定容量和可控行为。

23 PriorityQueue

- 实现:基于二叉堆(通常是数组形式的最小堆),在 JDK 中

PriorityQueue是最小堆(最小元素优先)。 - 复杂度:

offer()/poll():O(log n)(上下调整堆)。peek():O(1)。remove(Object):O(n)(删除任意元素需要线性查找并重新堆化)。

- 元素要求:要么实现

Comparable,要么在构造时传入Comparator。不能保存null。 - 非线程安全:多线程需要外部同步或使用

PriorityBlockingQueue。 - 用途:任务调度、A* 算法的 open set、定时任务优先级管理(结合 DelayQueue/自定义时间比较器)。

- 实现细节:内部使用

siftUp/siftDown操作维持堆性质。

24 设计原则

面向对象的设计模式有七大基本原则:

- 开闭原则(Open Closed Principle,OCP)

- 单一职责原则(Single Responsibility Principle, SRP)

- 里氏代换原则(Liskov Substitution Principle,LSP)

- 依赖倒转原则(Dependency Inversion Principle,DIP)

- 接口隔离原则(Interface Segregation Principle,ISP)

- 合成/聚合复用原则(Composite/Aggregate Reuse Principle,CARP)

- 最少知识原则(Least Knowledge Principle,LKP)或者迪米特法则(Law of Demeter,LOD)

| 标记 | 设计模式原则名称 | 简单定义 |

|---|---|---|

| OCP | 开闭原则 | 对扩展开放,对修改关闭 |

| SRP | 单一职责原则 | 一个类只负责一个功能领域中的相应职责 |

| LSP | 里氏代换原则 | 所有引用基类的地方必须能透明地使用其子类的对象 |

| DIP | 依赖倒转原则 | 依赖于抽象,不能依赖于具体实现 |

| ISP | 接口隔离原则 | 类之间的依赖关系应该建立在最小的接口上 |

| CARP | 合成/聚合复用原则 | 尽量使用合成/聚合,而不是通过继承达到复用的目的 |

| LOD | 迪米特法则 | 一个软件实体应当尽可能少的与其他实体发生相互作用 |

其中,单一职责原则、开闭原则、迪米特法则、里氏代换原则和接口隔离原则就是我们平常熟知的SOLID。

小结 + 典型面试追问准备

- HashMap、ConcurrentHashMap、ArrayList/LinkedList、String 系列、equals/hashCode、volatile/final/static 是高频点;务必能画数据结构示意图与关键代码路径(比如 put/get 的流程图)。

- 练习写出

equals/hashCode的正确实现样例,能解释 HashMap 的扩容和树化阈值(16/0.75/8/64)。 - 熟悉

synchronizedvsLockvsvolatile的语义与性能差异;理解 JMM 基础(happens-before,final 字段语义)。 - 对并发集合,能解释为什么

ConcurrentHashMap.get()不加锁仍安全(volatile 可见与不变性保证)。

数据库基础-牛客面经八股

1. MySQL 的存储引擎有哪些?它们之间有什么区别?默认使用哪个?

常见引擎(并非全部):

- InnoDB:事务性引擎,支持 ACID、行级锁、MVCC、外键、崩溃恢复(redo/undo、doublewrite)、自带缓冲池(buffer pool)。适合 OLTP。默认引擎(MySQL 5.5+)。

- MyISAM:非事务、表级锁、较小 IO 延迟、全文索引(早期),恢复能力弱,不支持外键。适合只读或读多写少场景。

- MEMORY(HEAP):把数据放内存,访问极快,但断电丢失,适合临时表或高速缓存。

- CSV:把每行存为 CSV 文件,便于导/出,但功能非常有限。

- ARCHIVE:适合归档写入(高压缩、只追加、只支持 INSERT/SELECT),不能索引(或索引能力弱)。

- NDB(MySQL Cluster):分布式内存存储引擎,适用于高可用、分布式场景(复杂运维)。

- 其他第三方/变体:如 MyRocks(Facebook 的 RocksDB 后端,写放大与压缩优化)、TokuDB 等。

区别要点:

- 事务支持(InnoDB 支持,MyISAM 不支持)。

- 锁粒度(InnoDB 行级锁,MyISAM 表级锁)。

- 崩溃恢复(InnoDB 有 redo/undo/doublewrite),MyISAM 依赖修复工具。

- 存储与索引实现细节(索引类型、压缩、聚簇索引等)。

- 性能定位:InnoDB 通常更平衡适合并发写;MyISAM 在单纯读场景可能略快。

默认引擎:现代 MySQL(5.5 之后)默认是 InnoDB。

2. MyISAM 与 InnoDB 的区别?如何选择?

关键差别:

- 事务:InnoDB 支持事务(ACID),MyISAM 不支持。

- 锁:InnoDB 行级锁(更高并发性);MyISAM 表级锁(写操作会阻塞读写)。

- 崩溃恢复:InnoDB 支持 redo/undo + doublewrite(较安全);MyISAM 恢复能力差(需 myisamchk)。

- 外键:InnoDB 支持外键约束;MyISAM 不支持。

- 存储:InnoDB 有聚簇索引(主键与数据同 B+Tree),MyISAM 主数据与索引分离(非聚簇)。

- 全文搜索:历史上 MyISAM 支持全文索引;新 MySQL 版本 InnoDB 也支持全文索引。

- IO & 性能:MyISAM 在简单读场景可能低延迟;InnoDB 在高并发写/读混合时更好。

如何选择:

- 需要事务/并发写/外键/崩溃安全 → InnoDB。

- 只读或极少写、对数据一致性要求低、老系统或特殊查询(极短)→ MyISAM 可考虑,但现在建议首选 InnoDB。

- 如果是高速缓存性质短期数据可考虑 MEMORY。

- 总体建议:生产 OLTP 系统用 InnoDB。

3. InnoDB 是如何存储数据的?

核心概念(实现层):

- 表空间(tablespace):InnoDB 用 tablespace 存储数据页与索引页。可以是共享系统表空间 (

ibdata1) 或innodb_file_per_table=ON(每表单文件 .ibd)。 - 页(page):默认页大小 16KB(可配置)。页是读写的最小单位,页里包含多个记录(row)与链表/目录。

- B+ 树索引:

- 聚簇索引(clustered index):主键索引就是数据的物理组织(叶子节点存放完整行)。若无主键,InnoDB 会选择第一个非 NULL 唯一键或内部生成隐式列作为聚簇键。

- 二级索引(secondary index):非主键索引的叶子存放索引列 + 主键值(作为指向聚簇索引的“指针”);因此二级索引查到行后还需回聚簇索引读取完整行(称回表)。

- 事务日志:

- Redo log(重做日志):预写日志(WAL),用于崩溃恢复(ib_logfile*)。

- Undo log(回滚/MVCC):用于多版本并发控制(MVCC),支持一致性读(快照读),undo 存在系统表空间或独立 undo tablespace。

- Doublewrite buffer:写入磁盘前把页写入 doublewrite 区,防止半页写入导致损坏(提高崩溃安全)。

- Buffer Pool:InnoDB 的核心缓存区,缓存数据页和索引页,读写都尽量在 buffer pool 完成以减 IO。

- MVCC(多版本并发):

- 通过在行上或 undo-log 中保存旧版本来实现一致性读(Read View)。读写隔离依赖 undo 来提供快照。

- 默认隔离级别

REPEATABLE-READ(MySQL 特性:使用间隙锁 + next-key lock 以避免幻读)。

- 插入缓冲/变更缓冲(change buffer/insert buffer):延迟索引操作合并以提高插入吞吐(针对非聚簇索引)。

- 行格式:REDUNDANT/COMPACT/DYNAMIC/COMPRESSED;大字段(BLOB/TEXT 或超长 VARCHAR)可 off-page(只在行内留 20 字节指针),减少行膨胀。

4. MySQL 一行记录是怎么存储的?

以 InnoDB 为例(聚簇行存放在 B+ 树叶子页):

- 页头 + 页目录(slot) + 记录区 + 空闲区 + 页尾/校验。页头包含 LSN、Page number 等元信息;页尾可能有校验信息。

- 记录格式(简化):

- 记录头(记录类型、链表指针、事务信息、记录长度)。

- NULL 位图(标记哪些列为 NULL)。

- 记字段数据:固定长度列(定长)先写,变长列(VARCHAR、BLOB)写长度与内容;若内容很长,InnoDB 的 DYNAMIC/COMPRESSED 行格式会把大字段存放到外部 overflow 页,行内只保留指针(通常 20 字节)。

- 二级索引条目:只包含索引列 + 主键(作为定位聚簇行的“引用”)。因此二级索引不会重复存储全部行内容,节省空间但会导致回表。

MyISAM:每行存在数据文件(.MYD),索引在 .MYI;没有聚簇索引,索引里存偏移量指向数据文件中的行。

5. 详细描述一条 SQL 在 MySQL 中的执行过程

高层步骤(客户端到存储引擎):

- 客户端层:应用通过连接(Connector/J 等)发送 SQL 到 MySQL Server(线程池/one-thread-per-connection)。

- 连接与认证:MySQL 验证账号/权限(authentication plugin、grant tables)。

- 解析(Parser):SQL 被词法/语法解析器转换为解析树(parse tree),检查语法正确性。

- 预处理 / 语义分析:解析树变成 parse tree 的语义检查,解析表名、列名是否存在,权限检查。

- 重写/视图/子查询优化:展开视图、优化子查询(视具体版本,子查询可重写为 JOIN)、派生表(derived table)处理(有时会创建临时表)。

- 查询优化器(Optimizer):

- 根据表统计信息、索引、条件,生成若干候选执行计划(访问路径、连接顺序、连接算法)。

- 使用代价模型(cost estimates)选择最优计划。会决定是否使用索引、哪种索引、join 顺序等。

- 执行引擎(Execution Engine)/计划执行:

- 根据执行计划逐步执行:遍历表、应用 WHERE、做 JOIN、聚合 GROUP BY、排序 ORDER BY、生成结果行。

- 在执行过程中与**存储引擎(Handler API)**交互做实际 IO(InnoDB、MyISAM)。

- 存储引擎层(如 InnoDB):

- 执行页读取、索引查找、事务隔离控制(锁、MVCC)、读写缓冲、写日志(redo)等底层操作。

- 返回结果:执行引擎把结果发送回客户端;若是写操作,会提交事务(若是自动提交或显式提交),redo log 刷盘(强制或延迟由配置决定)。

- 统计/缓存更新:query cache(若启用且有效,但在新版本中已弃用/移除),慢查询记录等。

注意:实际过程包含很多优化(例如谓词下推、索引条件下推、block nested loop、batched key access、histograms 等),不同 MySQL 版本细节不同,但总体流程如上。

6. MySQL 的查询优化器如何选择执行计划?

核心机制:

- 基于成本的优化器(CBO):使用统计信息(表基数、索引基数、分布直方图等)估算每个访问路径(全表扫描、索引范围、索引唯一查找等)的代价(IO、CPU)。

- 统计信息来源:通过

ANALYZE TABLE更新,也会由执行过程中动态采样。MySQL 8 引入了更精细的直方图支持(更好估算非均匀分布列)。 - 选择因素:

- 索引可用性(是否存在合适索引、是否为覆盖索引)。

- 选择性(selectivity)——该索引能筛掉多少行。

- 表大小(行数)、列基数。

- 连接顺序、连接算法(Nested-Loop 为主;有时使用 Index Merge、Block Nested Loop、Hash Join 在某些版本/场景可用)。

- 是否可以进行

index-only(覆盖索引)避免回表。 - 物化临时表 vs on-the-fly 的成本(派生表策略)。

- 搜索策略:MySQL 会根据 join 数量与成本在一定规则下枚举 join 顺序(对较多表会采用启发式或限制性搜索以避免指数爆炸)。

- 优化器提示与开关:可以通过

USE INDEX/FORCE INDEX/STRAIGHT_JOIN/OPTIMIZER_SWITCH等影响计划选择。 - 上手实践:使用

EXPLAIN/EXPLAIN ANALYZE(MySQL 8)查看执行计划、识别 full table scan、filesort、temporary 的使用,并据此调整索引/SQL 重写/统计信息。

7. SQL 中 SELECT、FROM、JOIN、WHERE、GROUP BY、HAVING、ORDER BY、LIMIT 的执行顺序?

逻辑/标准的处理顺序(简化):

- FROM(包含 JOIN,并先应用 ON 条件用于连接裁剪/过滤)

- WHERE(行级过滤)

- GROUP BY(分组)

- HAVING(对分组结果的过滤)

- SELECT(投影、表达式计算)

- DISTINCT(去重,如果有)

- ORDER BY(排序)

- LIMIT(限制返回行数)

注意:

- 子查询 / 派生表 在其内部先执行(或由优化器重写)。

- 优化器在物理执行上可能重排序或采用更有效算法(例如把谓词下推到存储引擎),但逻辑意义遵循以上顺序。

ON与WHERE的区别:ON常用于连接条件(可以影响是否为外连接保留行);WHERE在连接后对整行做最终过滤。

8. MySQL 中的数据排序(ORDER BY)是如何实现的?

两种主要方式:

- 走索引顺序(避免 filesort):

- 当

ORDER BY的列正好与一个可用索引的左前缀相匹配,并且排序方向与索引一致,且查询没有要求额外的排序列或必须在不同表之间合并排序,优化器可以直接按照索引读取数据,无需显式排序(称为 “Using index”)。 - 覆盖索引(索引包含所有 SELECT 列)还能避免回表。

- 当

- Filesort(外部排序):

- MySQL 会把需要排序的记录(或键)取出来,放到内存(sort_buffer)里排序;如果超出内存,会使用临时文件(磁盘)进行外部排序。EXPLAIN 会显示

Using filesort。 - 实现常见为 quicksort/mergesort 的变体:对于 large datasets,会分段排序并归并(外部排序)。

- 若查询还需要 group by + order by,会可能生成临时表(

Using temporary),再排序。

- MySQL 会把需要排序的记录(或键)取出来,放到内存(sort_buffer)里排序;如果超出内存,会使用临时文件(磁盘)进行外部排序。EXPLAIN 会显示

- 优化点:

- 为 ORDER BY 列建立合适的索引(左前缀),并尽量让查询使用覆盖索引,能显著避免 filesort。

- 减少 sort_buffer_size 不要盲目增大;更好的方法是优化索引与 SQL。

- EXPLAIN 线索:

Using filesort→ 排序发生(可能开销大)。Using index与Using where等组合能提示是否能走索引避免排序。

9. 为什么阿里巴巴 Java 手册不推荐使用存储过程?

基于工程实践的常见理由(多组织采用一致性观点):

- 可维护性差:业务逻辑分散在应用代码与数据库存储过程里,版本控制、代码 review、测试、CI/CD 管理不便。

- 可测试性差:存储过程难以做单元测试,缺少成熟的构建/测试生态。

- 可移植性差:不同数据库的存储过程语法差异大,锁定供应商(vendor lock-in)。

- 复杂逻辑不适合:复杂业务逻辑写在 DB 层会降低可读性、让 DB 成为业务瓶颈。

- 伸缩性限制:数据库的横向扩展(读写分离、分库分表)会使存储过程管理复杂;应用层更易于水平扩展。

- 运维与安全:频繁修改存储过程需要谨慎部署,不当操作可能影响全表数据。

但并不是绝对禁止:存储过程在某些场景仍有价值(复杂的数据库内聚合计算、减少网络往返、一些数据临近处理),关键是权衡与团队能否做好治理(版本管理、测试与文档)。

10. 如何实现数据库不停服迁移?

常见做法与工具(线上敏感操作的通用流程):

A. Schema 变更(DDL 无停机化策略):

- 使用在线 DDL 工具:gh-ost、pt-online-schema-change(pt-osc)(Percona),原理通常是:

- 创建目标结构的 shadow 表(新表)。

- 全量复制旧表数据到新表(分批、无锁读取)。

- 使用触发器或 binlog 双写在复制期间捕获并应用变更(保持同步)。

- 切换(RENAME TABLE 原子操作)完成替换(极短时间锁),或利用应用层路由切换表名。

- 清理旧表与中间对象。

- MySQL 新版本支持 instant / in-place DDL(对部分操作如某些 ADD COLUMN 可瞬时完成),要根据 MySQL 版本能力安排。

B. 数据迁移(不停服搬库):

- 使用逻辑复制/同步:

- 使用 replica(基于 binlog)把流量从老库写到新库,切换读写角色(master-master / master-slave 切换),或多写短期双写,最后切走流量。

- 使用工具:gh-ost, pt-osc, MaxScale, Canal, Debezium(CDC)等。

- 使用物理复制/备份恢复:

- 使用

Percona XtraBackup做热备恢复到新实例,再提升为主库(需注意 binlog 位点迁移与增量)。

- 使用

- 切换策略:

- 先做读切换:把只读流量切到新库进行验证。

- 再短暂降级写或使用双写/幂等写策略,最终切换写主。

- 最后回放或同步最后的 binlog。

实战注意:

- 自动化、灰度:分阶段灰度切换,避免一次性切换全量流量。

- 监控与回滚:详细监控(延迟、错误率),支持快速回滚方案。

- 数据一致性验证:使用 checksum(pt-table-checksum)等验证数据一致性。

- schema migration 工具链:Liquibase/Flyway 管理 schema 版本,配合在线 DDL。

- 压力与资源:复制过程中会对源库添加额外负载,提前评估资源与窗口。

11. UNSIGNED 属性有什么用?

- 只适用于整数类型(TINYINT/SMALLINT/MEDIUMINT/INT/BIGINT):

UNSIGNED表示无符号,范围从 0 到 2^N − 1(例如 INT UNSIGNED 范围 0 ~ 4294967295)。 - 作用:把同样字节数的上限往正数方向翻倍(允许更大正数),但不能存负数。

- 注意点:

- 查询/比较时注意有符号与无符号的比较规则(有时会隐式转换)。

- 与应用语言映射(Java 的 int 是有符号)要小心越界与类型不匹配。

- 存储大小(字节数)不变,只有数值范围变化。

12. MySQL 中 int(11) 的 11 表示什么?

(11)只是显示宽度(display width),仅在与ZEROFILL一起使用时生效(会用前导零补齐到显示宽度)。并不影响存储大小或范围。- 实际存储仍由 INT 类型决定(4 字节)。

- 从 MySQL 8.0.17 起,整数显示宽度已被弃用(除了 TINYINT(1) 的布尔习惯),因此不要依赖这个数字表示精度或范围。

13. CHAR 与 VARCHAR 有何区别?

- CHAR(n):

- 固定长度(n 个字符),存储时不足部分用空格填充(右填充)。读取时空格可能被忽略(在比较与一些行为中)。

- 适合长度固定的小字段(例如国家码、固定码)。

- 存取更简单、性能稳定(少指针/长度字节开销)。

- VARCHAR(n):

- 可变长度,用 1 或 2 字节保存长度前缀(长度 ≤ 255 用 1 字节,≥256 用 2 字节,取决于实际定义与字符集),存储仅占用实际字符 + 前缀字节。

- 适合变长字符串(名字、描述等)。

- 存储与索引注意:

- InnoDB 行最大长度限制(受整行 65KB 限制影响),长 VARCHAR 可能 off-page(BLOB/TEXT 处理类似)。

- CHAR 比 VARCHAR 更适合短且固定的值;VARCHAR 更节省空间但带有长度前缀。

14. VARCHAR(100) 与 VARCHAR(10) 的区别?

- 主要差别是允许的最大长度(100 vs 10 字符),以及索引前缀限制和潜在行大小影响。

- 实际影响:

- 若使用 UTF8/utf8mb4,100 字符可能最多占用 400 字节(4 bytes/char),会影响最大行大小与索引长度(索引长度以字节计算)。

- 索引时若

VARCHAR(100)太长,可能需要指定索引前缀(INDEX(col(50)))以不超过索引长度限制。 - 性能上,若字段大且频繁被读取,IO 与缓存压力更大。

- 建议:为字段设置合理上限(既能容纳业务数据又不过分浪费),并考虑字符集的字节长度。

15. DECIMAL 与 FLOAT/DOUBLE 的区别?

- DECIMAL:

- 定点(精确)数值,用于金融场景避免舍入误差(用人眼可理解的十进制精度)。在 MySQL 内部通常以压缩的二进制形式或 BCD packs 存储(每几个十进制位打包),不是 IEEE 浮点。

- 定义如

DECIMAL(M,D):总位数 M,小数位 D(注意 M 包括小数点两侧总位数)。 - 优点:精确、适合金钱。缺点:运算可能比浮点慢,存储更复杂。

- FLOAT / DOUBLE:

- 浮点数(近似),基于 IEEE 754,表示为二进制近似。

FLOAT单精度,DOUBLE双精度。 - 适合科学计算、需要范围大但对微小舍入误差可容忍的场景。

- 浮点数(近似),基于 IEEE 754,表示为二进制近似。

- 结论:存金额用 DECIMAL(或整数 cents),浮点用于近似计算。

16. DATETIME 与 TIMESTAMP 的区别?

- 存储范围与字节:

DATETIME:可表示'1000-01-01 00:00:00'到'9999-12-31 23:59:59'(8 字节传统实现;自 5.6 支持微秒扩展)。TIMESTAMP:通常以 UTC 的 Unix 时间戳为基础(较早实现 4 字节,范围受限制大约 1970-2038 在某些实现),MySQL 新版本扩展也有改进。

- 时区处理:

TIMESTAMP会根据连接/服务器时区进行存储时转换(存储为 UTC,显示时转换为当前会话时区),因此适合表示“瞬间(时点)”。DATETIME不会随时区自动转换,存储的是“本地时间点”。适合表示固定本地时间,如日程表(不希望时区转换)。

- 默认值 / CURRENT_TIMESTAMP:

TIMESTAMP更早支持CURRENT_TIMESTAMP作为默认值/自动更新;现代 MySQL 已允许DATETIME使用CURRENT_TIMESTAMP(从 5.6.5 起)。 - 建议:

- 表示事件时间点(跨时区)使用

TIMESTAMP或统一存 UTC(并在应用层转换)。 - 表示本地日历时间或无时区语义用

DATETIME。

- 表示事件时间点(跨时区)使用

17. NULL 与 '' 有什么区别?

NULL:未知/缺失值;不是值,表示“没有值”。- 与任何比较(

=,<>)的结果为NULL(即未知);必须使用IS NULL/IS NOT NULL判断。 - 聚合函数(如

SUM,AVG)通常忽略 NULL 值;COUNT(col)不计 NULL,COUNT(*)计行数包括 NULL 列。

- 与任何比较(

'':空字符串,是一种确定的值(长度 0 的字符串),不等于 NULL。- 索引与存储:NULL 在索引中有特殊表示;空字符串按照字符存储。

- 实践:语义不同 — 把“未填写”与“填写为空字符串”区分开来通常更有意义。尽量选择一种约定并统一(例如允许 NULL 表示未填写)。

18. Boolean 类型在 MySQL 中如何表示?

- MySQL 中没有独立的原生

BOOLEAN存储类型;BOOLEAN是TINYINT(1)的别名(0 假/false,非 0 为 true 通常视为 true)。 - 也可以用

BIT(1)来代表布尔(但读写和表达上需要注意转换)。 - 实践:习惯用

TINYINT(1)或在应用层把 0/1 映射为 false/true。

19. 为什么不推荐使用 TEXT 和 BLOB?

原因与权衡:

- 索引限制:不能对整列做索引(需要前缀索引),并且索引长度受限(与字符集、InnoDB 页布局相关);全文检索需专门的全文索引或 ElasticSearch。

- 性能与 IO:大对象(LOB)多数情况下会被存放到页外(off-page),增加额外 IO 与指针回访成本;排序/分组涉及临时表时可能导致大量磁盘 I/O(临时表落盘)。

- 内存/缓存问题:查询含大字段会拉大内存使用(临时表、buffers、网络传输),影响并发能力。

- 可维护性:大对象在备份/恢复/复制时显著增加备份大小与时间。

- 替代方案:若文件较大(图片、音频、视频),通常推荐把文件放在对象存储(S3/OSS)或文件系统,并在 DB 中保存引用 URL/元数据;若确实需要 DB 存储(事务性要求),可以用 BLOB,但需注意分块/流式处理。

实践建议:短文本用 VARCHAR;长文本搜索用专门搜索引擎(Elasticsearch)或 InnoDB 的全文索引;大二进制数据建议外部存储。

20. 在 MySQL 中存储金额应使用什么数据类型?

- 推荐:

DECIMAL(precision, scale)(例如DECIMAL(13,2)或DECIMAL(10,2)视业务而定),因为 DECIMAL 提供精确的十进制表示,避免浮点舍入误差。 - 备选:整型存“最小单位”(例如 cents),用

INT或BIGINT存储(性能好,简单准确),显示时按 100/1000 转换。 - 建议:选定单位与精度并在全系统一致使用(数据库、API、前端)。

21. MySQL 如何存储 IP 地址?

IPv4:

存为整数:

INT UNSIGNED+INET_ATON()/INET_NTOA()函数转换。优点:占用 4 字节、索引速度快。1

2INSERT INTO t (ip) VALUES (INET_ATON('192.168.0.1'));

SELECT INET_NTOA(ip) FROM t;

IPv6:

- 使用

VARBINARY(16)(或BINARY(16)),使用INET6_ATON()/INET6_NTOA()进行转换(兼容 IPv4/IPv6)。也可用CHAR(39)存文本表现,但二进制更紧凑且便于索引。

- 使用

注意:比较与排序最好保持二进制/整数形式,减少字符串处理开销;存储时要考虑字节序(INET_ATON/NTOA 处理好)。

22. 什么是数据库视图?

- 视图(VIEW):基于 SQL 查询的虚拟表,定义后可以像表一样查询。视图并不总是存储数据(除非是物化视图,MySQL 本身不原生支持物化视图)。

- 用途:

- 抽象复杂查询、封装业务逻辑、权限控制(给用户只读视图)、简化客户端查询。

- 类型:

- 可更新视图:在满足一定条件时(单表、无聚合、无 DISTINCT、无 GROUP BY、无 LIMIT 等)可以通过视图执行 INSERT/UPDATE/DELETE。

- 不可更新视图:含聚合、分组、连接等,不能直接更新。

- 性能:视图是查询的“别名”,执行时会把视图展开为真实查询,复杂视图会带来性能影响;对于频繁计算的大查询,可以考虑物化策略(手工维护的物化表)。

23. 什么是数据库游标?

- 游标(Cursor):在存储过程/函数或数据库会话中用于逐行处理结果集的机制。游标允许你在 PL/SQL/存储过程里按顺序取出行并逐行处理。

- MySQL 游标特点:

- 在存储过程中

DECLARE cursor_name CURSOR FOR select_statement; OPEN cursor_name; FETCH cursor_name INTO ...; CLOSE cursor_name; - MySQL 的游标通常是只进/只读(forward-only, read-only),不像高级 DB(Oracle)支持可滚动游标。

- 在存储过程中

- 使用场景:需要逐行处理复杂逻辑、触发器或批量逐行迁移(但通常行处理效率差,优先考虑集合式 SQL 方案)。

- 性能提示:尽量避免在大数据量上使用游标逐行处理,改为批量 SQL 或应用层并行处理更高效。

24. 为什么不建议直接存储大对象(图片 / 音频 / 视频)?

主要问题:

- 备份/恢复压力:数据库备份会包含这些大文件,导致备份体积和恢复时间急剧上升。

- 性能与 IO:读写 BLOB 需大量 IO,影响数据库的整体响应性能;大对象导致内存/网络传输压力。

- 可扩展性:数据库扩容成本高;通常对象存储(S3/OSS)更易横向扩展、CDN 分发。

- 费用:托管 DB 存储成本高于对象存储系统。

- 替代方案:将大对象存对象存储或 CDN,数据库仅保存元数据(文件路径/URL、校验信息、版本)。

但有例外:若强事务一致性要求非常高或小文件数量有限,存 BLOB 有时更方便(例如需要事务回滚把文件也回滚),需评估权衡与方案。

25. 数据库的三大范式(1NF / 2NF / 3NF)是什么?

第一范式(1NF):

- 要求表中每个字段都是原子值(atomic),不能是集合或重复列。

- 例如,不应该有

phones字段保存多个电话号码(而应该拆成多行或独立表)。

第二范式(2NF):

- 在满足 1NF 的前提下,每个非主属性完全依赖于主键(解决部分依赖)。

- 针对复合主键:不能让非主属性只依赖于部分键。若有部分依赖,应拆表。

第三范式(3NF):

- 在 2NF 基础上,消除传递依赖(非主属性不能依赖于其他非主属性)。即每个非主属性直接依赖主键。

- 例如表

order(order_id, customer_id, customer_name),customer_name依赖于customer_id(非主属性→非主属性依赖),应拆成customer表。

补充:

- BCNF(Boyce–Codd NF) 更强,要求每个决定因素都是候选键。

- 范式优点:减少数据冗余,避免更新异常(插入/删除/更新异常),提高数据一致性。

- 范式代价 / 实战:

- 过度范式化会导致大量 join(性能开销),在 OLTP/OLAP/高性能场景常采用 适度反范式化(为查询性能牺牲部分冗余),并通过应用/触发器保证一致性或使用 ETL 保持数据同步。

- 实际设计通常是「第三范式为主,针对性能热点做有控制的反范式化或采用缓存/聚合表」。

最后:实战建议(综合)

- 生产数据库首选 InnoDB,设计表时优先考虑事务一致性与索引策略。

- 对 SQL 性能:学会用

EXPLAIN/EXPLAIN ANALYZE、慢查询日志、profiling 工具(pt-query-digest)定位问题;避免 SELECT *、滥用子查询;合理设计索引与覆盖索引。 - 对大数据/大对象:避免将大量二进制内容放 DB;使用对象存储 + DB 存元数据。

- Schema 变更:使用 gh-ost/pt-osc/ONLINE DDL 工具实现不停服。

- 金额用 DECIMAL 或 integer cents;IP 用整型或 VARBINARY(16);时间点用 TIMESTAMP(或统一存 UTC)。

JVM-牛客面经八股

JVM结构图

创建一个新对象 内存分配流程

1) JVM 内存模型(运行时数据区)——深入

JVM 将运行时数据区分为线程私有和多线程共享两类。

线程私有区域

- 程序计数器(PC):每线程一份,记录下一条要执行的字节码指令地址(用于执行字节码的分支控制)。如果线程在执行本地方法,该寄存器值为 undefined。

- 虚拟机栈(JVM Stack):每个线程一个栈,栈帧包含局部变量表、操作数栈、动态连接和方法返回地址。局部变量表保存基本类型和对象引用。栈溢出会抛出

StackOverflowError。 - 本地方法栈(Native Stack):专门用于处理本地方法(C/C++实现)调用的栈(HotSpot 在实际实现上可与 JVM Stack 合并或分开实现)。

多线程共享区域

- 堆(Heap):存放对象实例与数组,是 GC 管理的主要区域。堆细分为**年轻代(Eden + Survivor0/1)*和*老年代(Tenured)。堆还可能包含永久代或元空间(见下)。

- 方法区(Method Area)/元空间(Metaspace):存放类的元数据(Class 对象、常量池、静态变量、方法字节码)。JDK 8 起把 PermGen 替换为 Metaspace(在本地内存),可以通过

-XX:MaxMetaspaceSize限制。 - 直接内存(Direct Memory):不在 JVM 堆中,由

ByteBuffer.allocateDirect()等分配。虽然不在堆中,但会被本地内存耗尽导致 OOME(需要监控 native memory)。

重要细节

- 对象头(Mark Word + Klass Pointer)包含 GC 元信息(锁标记、哈希码、分代年龄等)和类指针(或 compressed klass pointer)。

- 对齐与压缩:

-XX:+UseCompressedOops(默认常开)影响对象引用大小与堆布局。 - 类加载器与类元数据泄露:类无法卸载的常见原因是类加载器仍有引用(静态集合、线程池、ThreadLocal 导致的 classloader leak)。

2) JVM 的垃圾回收算法

JVM 中常用/经典的 GC 算法原则与实现:

基础算法

- 引用计数(Reference Counting):为每个对象维护引用计数,计数为 0 时回收。缺点:无法处理循环引用。HotSpot 不采用此算法。

- 可达性分析(Trace-based):从 GC Roots 开始通过引用图遍历,标记活对象,未标记即回收。HotSpot 采用此方法。

回收策略

- 标记-清除(Mark-Sweep):标记所有可达对象,然后清除未标记对象。优点:实现简单;缺点:产生内存碎片。

- 标记-整理(Mark-Compact):标记活对象,然后将活对象压缩到一端,更新引用,消除碎片。适合老年代。

- 复制(Copying):把活对象从一个空间复制到另一个空间(两块半区或多个区),空出整个区域,避免碎片。优点:简单高效。常用于年轻代(Eden/Survivor)。

- 分代收集(Generational):根据对象存活期长短分代(年轻代/老年代)。年轻代使用复制算法(低成本),老年代使用标记-清除或标记-整理。因为大多数对象寿命短(弱生成假设),分代策略能显著提高性能。

现代收集器(概述)

- Serial GC:单线程收集,STW(Stop The World),适用于单核或小内存场景。

- Parallel(Throughput)GC:多线程并行回收,追求吞吐量,适合 batch、后台服务。

- CMS(Concurrent Mark-Sweep):并发标记清理,低暂停,使用并发阶段来减少 STW。已在新版 JDK 中被标注为过时/删除。

- G1(Garbage-First):把堆划分为 region,进行 region 级别回收与并行压缩,设计目标是可预测的暂停与高吞吐,现代服务器应用默认或推荐使用。

- ZGC / Shenandoah:以并发压缩为目标,追求极低停顿(几毫秒级甚至微秒级),适合超大堆与低延迟需求。

3) GC 的可达性分析

根(GC Roots)来源

- Java 虚拟机栈(栈帧中的本地变量表)中引用的对象。

- 方法区中的静态引用(静态变量)。

- 本地方法栈或 JNI 中的引用。

- 运行时常量池中直接引用(部分实现)。

- 其他 JVM 内部持有的引用(例如 ClassLoader 的引用)。

引用类型的语义

- 强引用(StrongReference):普通引用,GC 不会回收强引用对象。

- 软引用(SoftReference):在内存不足时回收,适用于缓存(

SoftReference)。 - 弱引用(WeakReference):在下一次 GC 时就可能回收,适用于 canonicalized mappings 等。

- 虚引用(PhantomReference):对象被回收后会把引用加入引用队列,可用于在对象被回收后做清理(配合 ReferenceQueue),并且

get()返回 null。

遍历算法

- 从 GC Roots 开始做图遍历(BFS/DFS)标记所有可达对象;未标记即为垃圾。

- 优点:能处理循环引用(与引用计数对比),是 HotSpot 的主流做法。

- 一些优化:

- 增量/并发标记:把标记工作分阶段与应用线程并发执行,以减少 STW。

- 卡表(Card Table)跟踪写入屏障:在分代收集中用于记录跨代引用(例如老->新),推动并行或并发回收优化。

4) CMS (Concurrent Mark Sweep) 垃圾回收器 —— 细节与调优

目标:尽量减少与应用线程的 STW 停顿(低延迟),主要用于老年代收集(年轻代通常用并行收集 ParNew)。

CMS 工作阶段(常见实现顺序)

- 初始标记(Initial Mark) — STW:标记直接可达的对象(通常从根开始快速标记与 GC Roots 直接关联的对象);时间较短。

- 并发标记(Concurrent Mark) — 与应用线程并发:遍历引用图标记可达对象。

- 并发预清理(Concurrent Preclean) —(可选)修正并发期间的部分浮动垃圾。

- 重新标记(Remark) — STW:修正并发标记期间因应用线程持有或释放引用导致的漏标(这一步相对短于传统全量标记,因为大部分工作已并发完成)。

- 并发清理(Concurrent Sweep) — 与应用线程并发:清理未标记对象并维护空闲链表。

- 并发重置/重组(Concurrent Reset):准备下一次 GC。

实现细节与问题

- 不做压缩(默认):CMS 清理不会压缩老年代,因此会留下内存碎片。碎片问题可能导致“内存足够但无法满足连续大对象分配”从而触发 Full GC。

- 并发模式失败(Concurrent Mode Failure):如果 CMS 无法在合理时间内完成并发回收(例如分配速率非常高或堆碎片太多),会触发 fallback:做一次 STW 的 Full GC(通常由 Serial GC 或 Parallel Old 执行),其停顿可能很长。

- 并发标记期间的“floating garbage”:由于并发执行,某些对象在标记时刚好变为不可达或变得可达,需要 re-mark 来修正。

- 配套 Young Collector:CMS 常与

ParNew(并行年轻代收集器)配合使用以减少年轻代停顿。

常见调优参数(典型)

-XX:+UseConcMarkSweepGC:开启 CMS(旧 JDK)。-XX:+UseParNewGC:并行年轻代与 CMS 协同。-XX:CMSInitiatingOccupancyFraction=XX:触发 CMS 的老年代占用率阈值(百分比)。默认例如 68 或 75,通常设置为 60~75,视应用而定。-XX:+UseCMSInitiatingOccupancyOnly:只使用指定阈值(避免 JVM 自适应更改)。-XX:+CMSParallelRemarkEnabled:并行 re-mark,减少 remark 停顿。-XX:+CMSClassUnloadingEnabled:允许 CMS 在并发过程中卸载类并回收元空间中无用的 class 元数据(防止 metaspace 泄漏)。

排查 CMS 问题

- 频繁 Full GC / Concurrent Mode Failure:查看 GC 日志(

-Xlog:gc*或-XX:+PrintGCDetails),识别是否为 CMS 失败导致的 Full GC;增大堆或调高CMSInitiatingOccupancyFraction,或减少老年代占用速率(减少晋升/减少内存占用)。 - 碎片问题:增加老年代大小,或在 Full GC 时触发压缩(Full GC 通常会做 compact);考虑切换到 G1(自带整理能力)。

- 已被弃用/移除:注意在新版本 JDK(例如 JDK 14+)CMS 已被移除或标记弃用,应优先考虑 G1、ZGC 或 Shenandoah。

5) G1 收集器(Garbage-First)

目标:在大堆场景下提供可预测的停顿目标(低延迟)与高吞吐,同时减少碎片。JDK9+ 的默认回收器通常为 G1(视 JVM 版本而定)。

核心思想

- Region(区域):G1 把堆划分为等大小的 region(通常 1MB~32MB,自动根据堆大小选择),每个 region 可以被逻辑地视为 Eden/Survivor/Old。

- 记忆集(Remembered Sets, RSet):为了记录跨 region 的引用(比如老区指向年轻区),G1 使用 RSet 来快速定位哪些 region 可能引用某 region 的对象,以便并发/并行回收时正确处理根集合。

- 并发标记阶段 + 混合回收:

- 初始标记(STW):短暂停顿做 root scanning(与 Eden GC 同步)。

- 并发标记(Concurrent Mark):并发地标记可达对象,构建 liveness 信息和 region 的垃圾率估算。

- 重新标记(Remark):STW,修正并发期间变更。

- 并发清理(Cleanup):确定哪些 region 应该被回收/合并(形成 Evacuation Set)。

- 混合回收(Mixed GC):在并发阶段之后执行若干次混合回收,回收年轻代 region 以及一些老年代 region,直到满足堆回收目标。

- Evacuation(搬迁):G1 回收采用“复制/搬迁”策略,把选中的 region 中的存活对象复制到其他空闲 region(可合并 region),以避免碎片并保持连续可用空间。

- Humongous objects:大对象(大于 region size/2)被视为 humongous,会占用连续多个 region,并直接交付给老年代(并采用专门策略回收)。

G1 的优点

- 区域化管理,支持并行、并发、压缩(搬迁)操作,降低碎片概率。

- 可以设置

-XX:MaxGCPauseMillis作为目标,G1 会尝试在此暂停目标下选择回收区域集合以满足目标(并不能保证严格实现)。 - 支持并发标记并回收老年代(mixed GC),提高可预测性。

重要参数与调优

-XX:+UseG1GC:启用 G1(现代 JDK 常为默认)。-XX:MaxGCPauseMillis=<N>:G1 尝试将停顿控制到 N ms(软目标)。-XX:InitiatingHeapOccupancyPercent=<pct>(默认 ~45):并发标记触发阈值(当堆占用达到此百分比时启动 concurrent marking)。-XX:G1HeapRegionSize=<size>:region 大小,自动调整但可显式设置(1MB~32MB),影响 humongous 阈值与 remembered set 管理开销。-XX:ConcGCThreads/-XX:ParallelGCThreads:并发/并行线程数目,通常与 CPU core 配置有关。-XX:MaxTenuringThreshold:对象晋升阈值控制(与 Survivor 区的年龄策略相关)。

诊断与问题

- Humongous 分配问题:大量 humongous 对象可能导致 region 被大量占用并影响 G1 的效率;可考虑调整 region size 或改用分块存储。

- Remembered Set 开销:对于很多跨 region 引用(即对象分布极为分散或写入热点多),RSet 更新开销高。

- GC 日志分析:使用

-Xlog:gc*:file=gc.log(JDK9+)或-XX:+PrintGCDetails(老方式),并用 GC 分析工具(GCEasy、GCViewer、JClarity)查看 pause、mixed GC 次数、humongous 比例等。

6) 类加载机制(加载、链接、初始化)

加载(Loading)

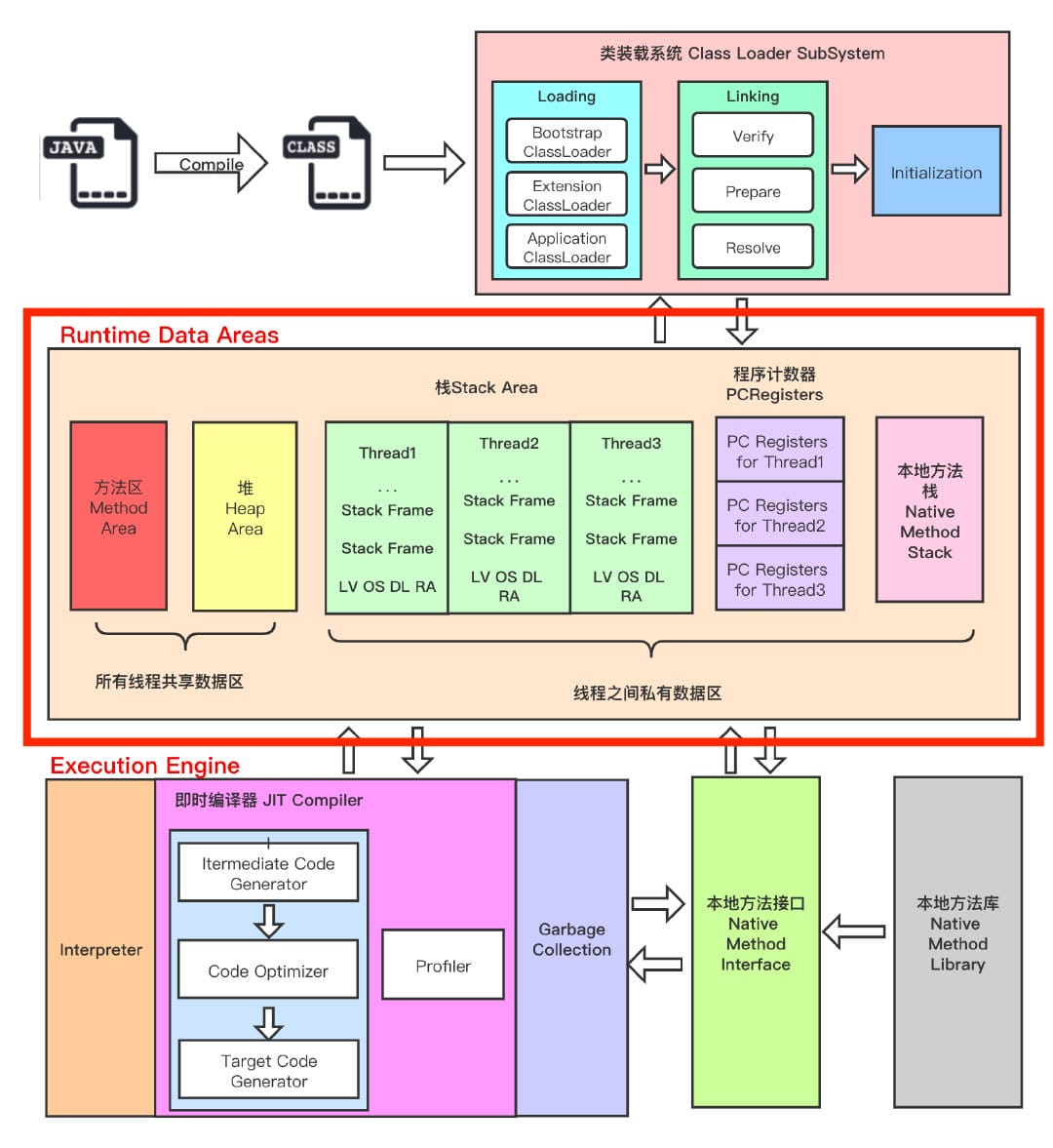

- ClassLoader 读取类的二进制字节流,将其转换为